AMD推出MI300X AI 芯片作为“生成式 AI 加速器”

2023年06月14日 由 Camellia 发表

344668

0

Lisa Su表示,能够在内存中运行整个400亿参数模型,意味着实际上减少了所需的GPU数量。

周二,AMD首席执行官Lisa Su在旧金山推出了一种芯片,它是该公司人工智能计算战略的核心,并以其巨大的内存容量和数据吞吐量为所谓的生成式AI任务提供支持,如大型语言模型等。

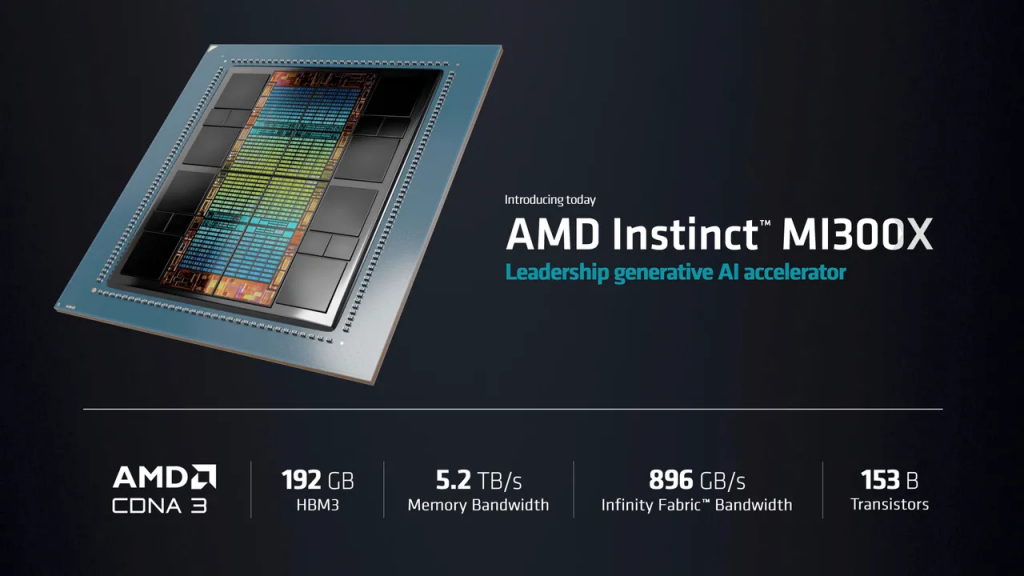

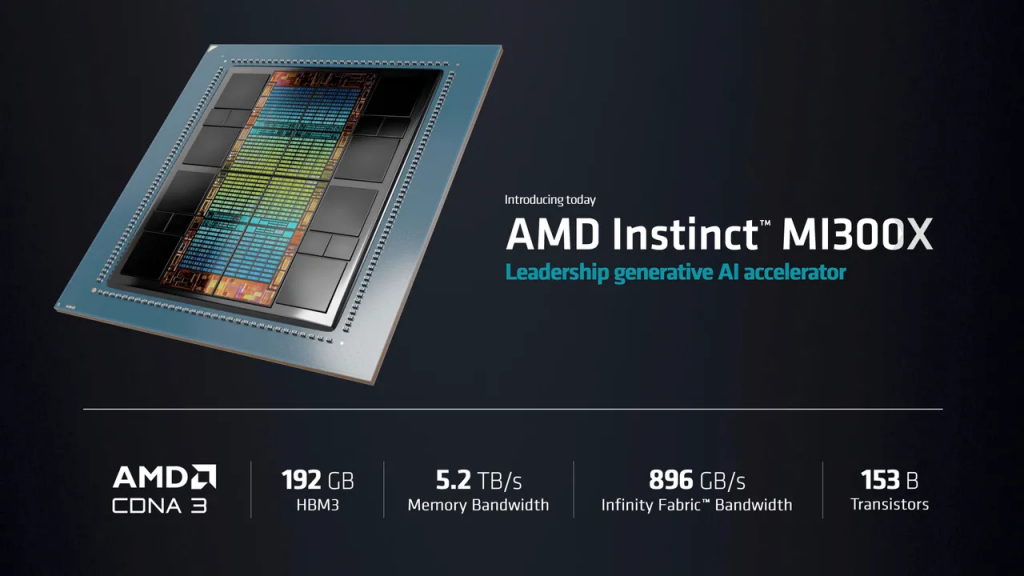

[caption id="attachment_52939" align="aligncenter" width="740"] AMD 的 Instinct MI300X GPU 具有多个 GPU“芯片”、192 GB 的 HBM3 DRAM 内存和每秒5.2 TB 的内存带宽。该公司表示,它是唯一可以处理内存中多达80亿个参数的大型语言模型的芯片。

AMD 的 Instinct MI300X GPU 具有多个 GPU“芯片”、192 GB 的 HBM3 DRAM 内存和每秒5.2 TB 的内存带宽。该公司表示,它是唯一可以处理内存中多达80亿个参数的大型语言模型的芯片。

AMD[/caption]

该部件被称为Instinct MI300X,是之前宣布的MI300A的后续版本。该芯片实际上是多个“芯片”的组合,这些单独的芯片通过共享存储器和网络链路连接在一个封装中。

在旧金山市中心费尔蒙特酒店受邀观众的见证下,Su将该部件称为“生成式AI加速器”,并表示其中包含的GPU芯片,即CDNA 3系列,是“专为人工智能和高性能计算(HPC)工作负载设计的。”

MI300X是该部件的“纯GPU”版本。MI300A是三个Zen4 CPU芯片与多个GPU芯片的组合。但是在MI300X中,CPU被换成了两个额外的CDNA 3芯片。

MI300X将晶体管数量从1460亿个增加到1530亿个,共享DRAM存储器从MI300A的128GB提高到192GB。同时,内存带宽从每秒800GB提高到每秒5.2TB。

“我们在这个产品中使用芯片非常具有战略意义,” Su表示,因为它可以混合和匹配不同类型的计算,如更换CPU或GPU。

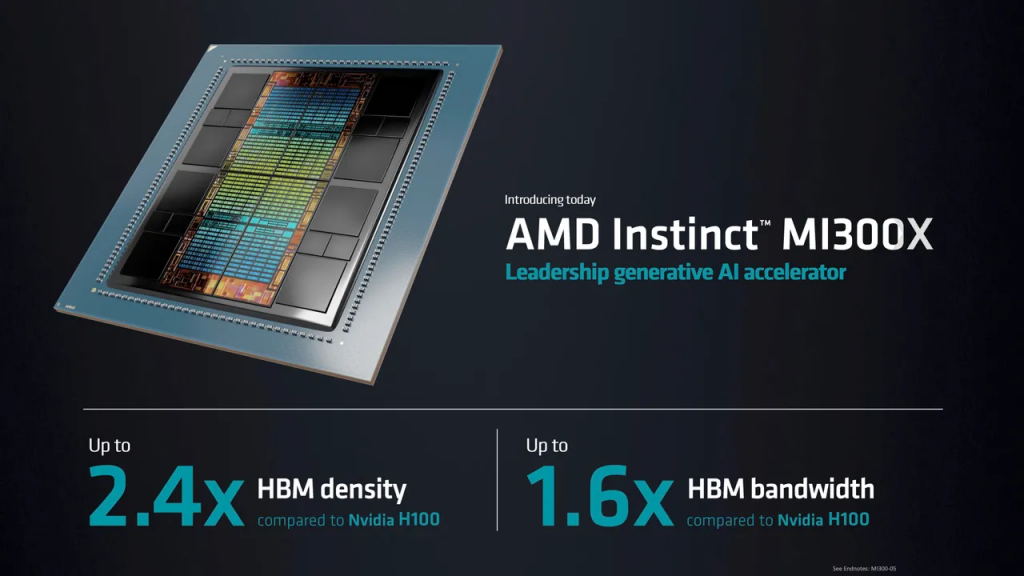

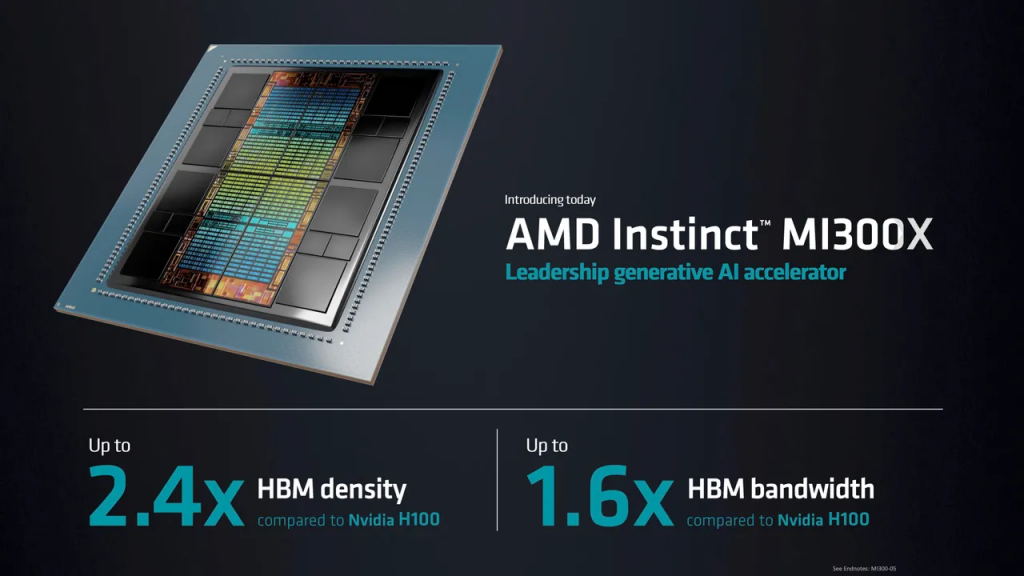

Su表示,MI300X将提供比英伟达的H100“Hopper”GPU高2.4倍的内存容量,以及1.6倍的内存带宽。

[caption id="attachment_52941" align="aligncenter" width="740"] AMD[/caption]

AMD[/caption]

Su表示,“生成式人工智能,大型语言模型已经改变了现有的格局。不论是训练还是推断,对更多的计算需求在呈指数级增长。”

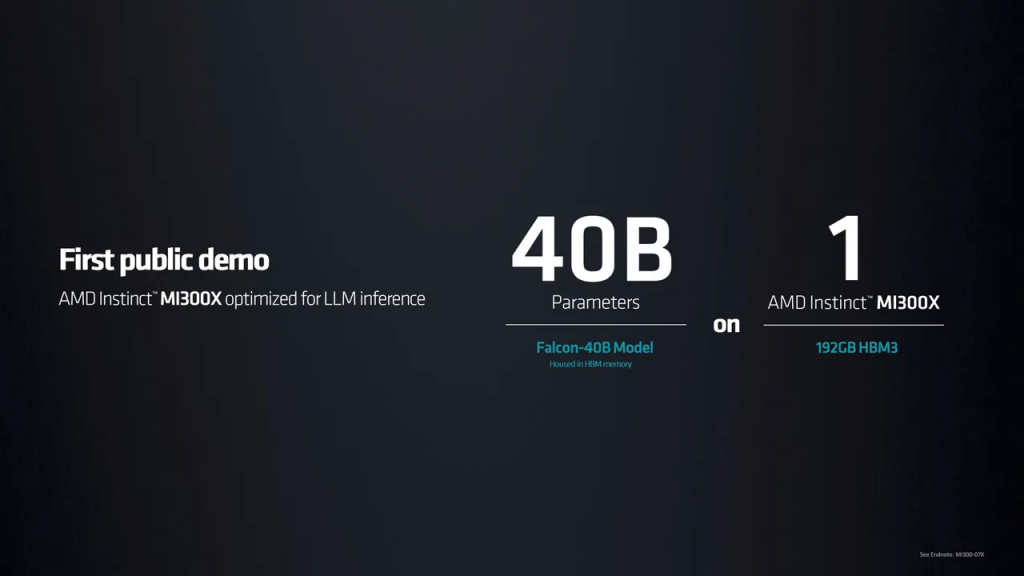

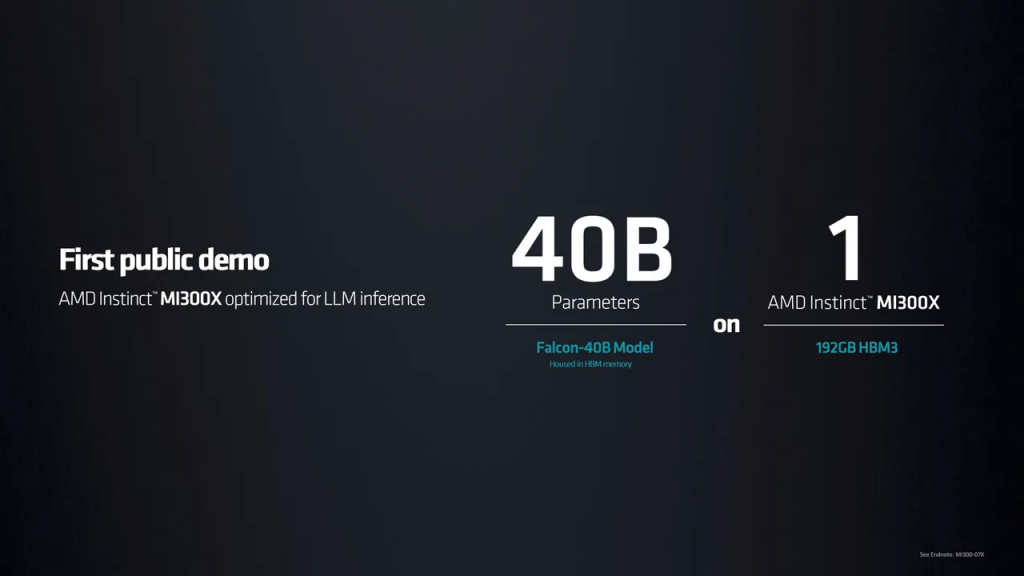

为了证明强大计算的必要性,Su展示了她所说的目前最流行的大型语言模型,开源的Falcon-40B。语言模型需要更多的计算,因为它们是用越来越多的神经网络“参数”构建的。Falcon-40B由400亿个参数构成。

她说,MI300X是第一款功能强大到可以完全在内存中运行这种规模的神经网络而不必在外部存储器之间来回移动数据的芯片。

Su演示了MI300X使用Falcon-40B创作了一首关于旧金山的诗。

她表示,“单个MI300X可以在内存中运行大约800亿个参数的网络模型。”

她继续说道,“与竞争对手相比,MI300X的内存容量和内存带宽分别提高了2.4倍和1.6倍,而所有这些额外的内存容量实际上为大型语言模型带来了优势,因为我们可以直接在内存中运行更大的模型。”

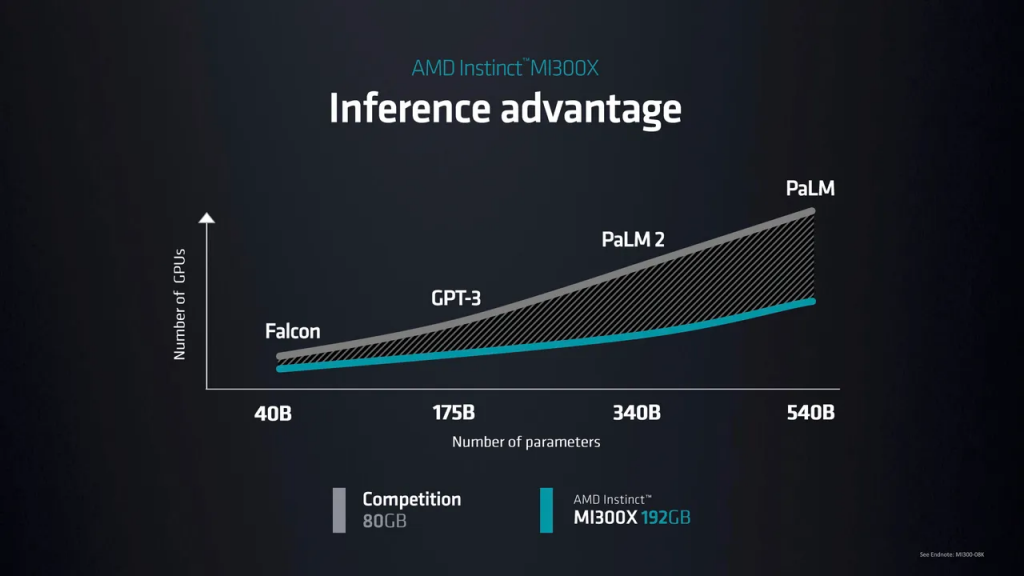

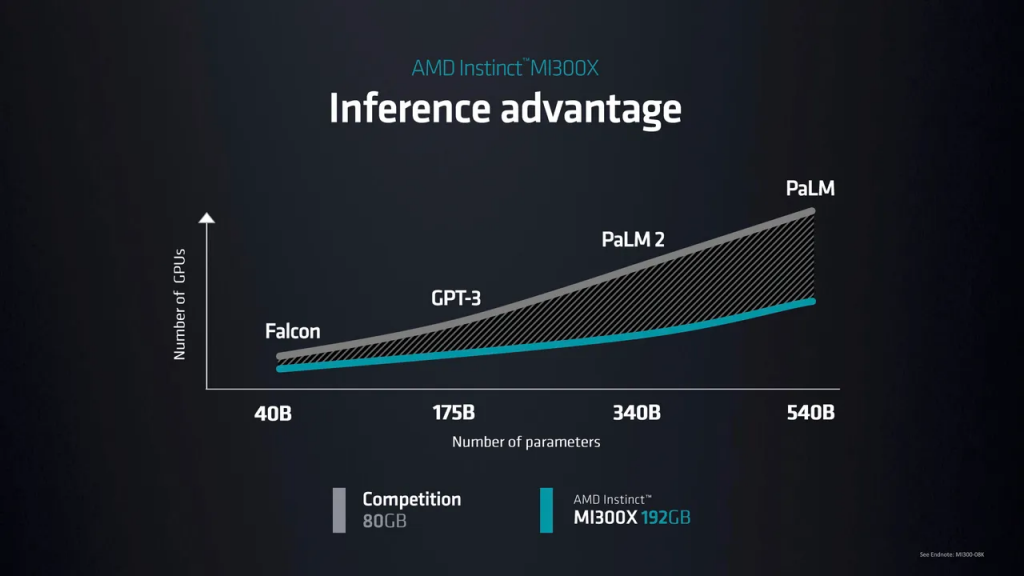

Su表示,能够在内存中运行整个模型,这意味着“对于最大的模型,它实际上减少了你所需的GPU数量,大大提高了性能,特别是推断的性能,同时减少了总拥有成本。”

[caption id="attachment_52942" align="aligncenter" width="740"] AMD[/caption]

AMD[/caption]

[caption id="attachment_52943" align="aligncenter" width="740"] AMD[/caption]

AMD[/caption]

“有了MI300X,你可以减少GPU的数量,随着模型规模的不断增长,这将变得更加重要。”

“有了更多的内存容量,更多的内存带宽,以及更少的GPU需求,我们可以在每个GPU上运行比以前更多的推理工作,"Su说。她说,这将降低大型语言模型的总拥有成本,使该技术更容易获得。

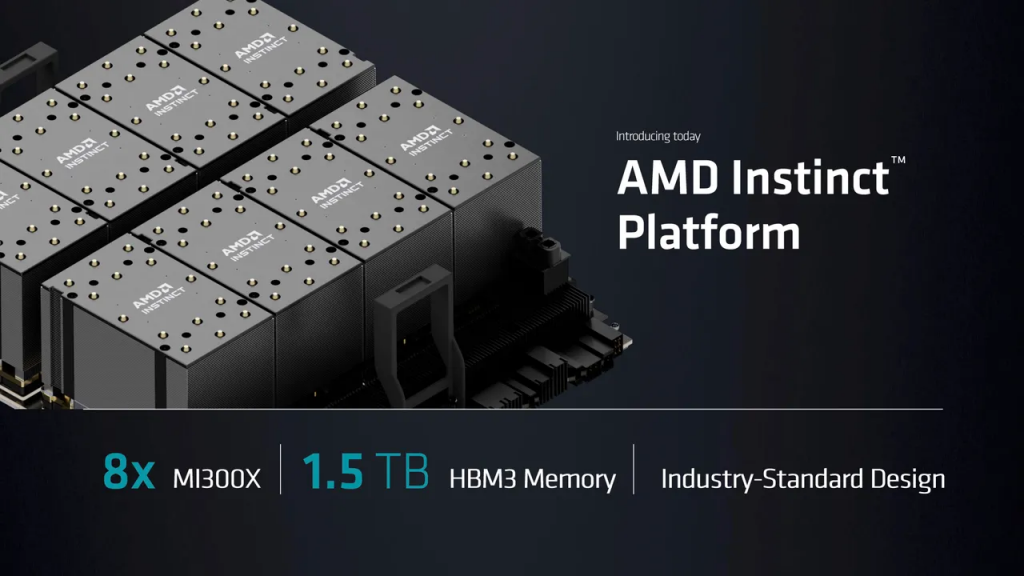

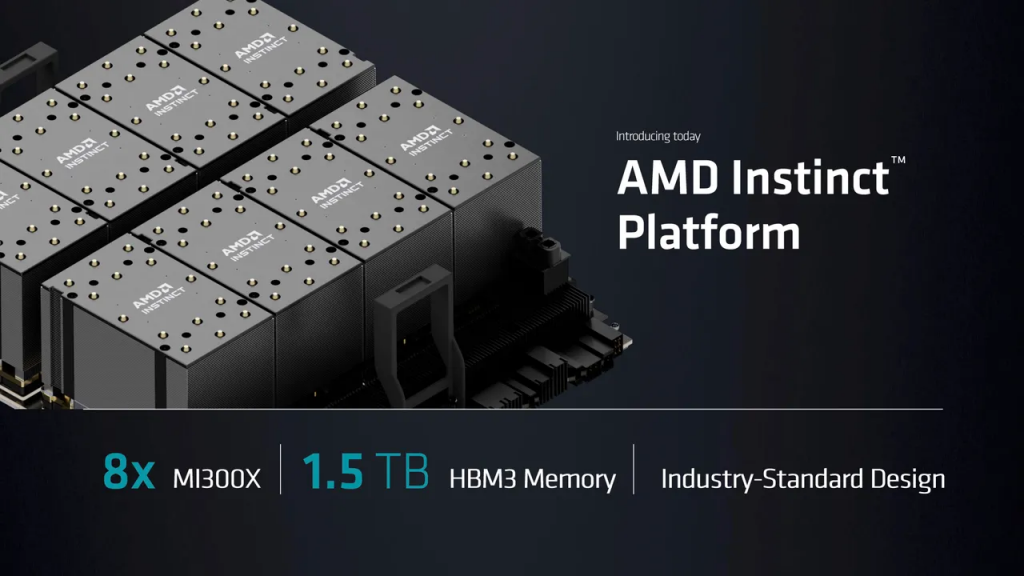

为了与英伟达的DGX系统竞争,Su推出了一系列人工智能计算机,即“AMD Instinct Platform”。第一个例子是将8台MI300X与1.5 TB的HMB3内存相结合。该服务器符合行业标准开放计算平台规范。

Su表示,“对于客户来说,他们可以在标准行业平台中使用所有这些内存中的AI计算能力,并直接投入到他们现有的基础设施中。”

[caption id="attachment_52944" align="aligncenter" width="740"] AMD[/caption]

AMD[/caption]

与MI300X不同,MI300A只是一个GPU,现有的MI300A将与英伟达的Grace Hopper组合芯片竞争,后者使用英伟达的Grace CPU和Hopper GPU,该公司上个月宣布该芯片已全面投入生产。

Su指出,MI300A正在被纳入能源部劳伦斯利弗莫尔国家实验室建造的El Capitan超级计算机中。

Su说,MI300A目前正作为样品向AMD客户展示,MI300X将于今年第三季度开始向客户提供样品。她说,这两款产品都将于第四季度批量生产。

来源:https://www.zdnet.com/article/amd-unveils-mi300x-ai-chip-as-generative-ai-accelerator/

周二,AMD首席执行官Lisa Su在旧金山推出了一种芯片,它是该公司人工智能计算战略的核心,并以其巨大的内存容量和数据吞吐量为所谓的生成式AI任务提供支持,如大型语言模型等。

[caption id="attachment_52939" align="aligncenter" width="740"]

AMD 的 Instinct MI300X GPU 具有多个 GPU“芯片”、192 GB 的 HBM3 DRAM 内存和每秒5.2 TB 的内存带宽。该公司表示,它是唯一可以处理内存中多达80亿个参数的大型语言模型的芯片。

AMD 的 Instinct MI300X GPU 具有多个 GPU“芯片”、192 GB 的 HBM3 DRAM 内存和每秒5.2 TB 的内存带宽。该公司表示,它是唯一可以处理内存中多达80亿个参数的大型语言模型的芯片。AMD[/caption]

该部件被称为Instinct MI300X,是之前宣布的MI300A的后续版本。该芯片实际上是多个“芯片”的组合,这些单独的芯片通过共享存储器和网络链路连接在一个封装中。

在旧金山市中心费尔蒙特酒店受邀观众的见证下,Su将该部件称为“生成式AI加速器”,并表示其中包含的GPU芯片,即CDNA 3系列,是“专为人工智能和高性能计算(HPC)工作负载设计的。”

MI300X是该部件的“纯GPU”版本。MI300A是三个Zen4 CPU芯片与多个GPU芯片的组合。但是在MI300X中,CPU被换成了两个额外的CDNA 3芯片。

MI300X将晶体管数量从1460亿个增加到1530亿个,共享DRAM存储器从MI300A的128GB提高到192GB。同时,内存带宽从每秒800GB提高到每秒5.2TB。

“我们在这个产品中使用芯片非常具有战略意义,” Su表示,因为它可以混合和匹配不同类型的计算,如更换CPU或GPU。

Su表示,MI300X将提供比英伟达的H100“Hopper”GPU高2.4倍的内存容量,以及1.6倍的内存带宽。

[caption id="attachment_52941" align="aligncenter" width="740"]

AMD[/caption]

AMD[/caption]Su表示,“生成式人工智能,大型语言模型已经改变了现有的格局。不论是训练还是推断,对更多的计算需求在呈指数级增长。”

为了证明强大计算的必要性,Su展示了她所说的目前最流行的大型语言模型,开源的Falcon-40B。语言模型需要更多的计算,因为它们是用越来越多的神经网络“参数”构建的。Falcon-40B由400亿个参数构成。

她说,MI300X是第一款功能强大到可以完全在内存中运行这种规模的神经网络而不必在外部存储器之间来回移动数据的芯片。

Su演示了MI300X使用Falcon-40B创作了一首关于旧金山的诗。

她表示,“单个MI300X可以在内存中运行大约800亿个参数的网络模型。”

她继续说道,“与竞争对手相比,MI300X的内存容量和内存带宽分别提高了2.4倍和1.6倍,而所有这些额外的内存容量实际上为大型语言模型带来了优势,因为我们可以直接在内存中运行更大的模型。”

Su表示,能够在内存中运行整个模型,这意味着“对于最大的模型,它实际上减少了你所需的GPU数量,大大提高了性能,特别是推断的性能,同时减少了总拥有成本。”

[caption id="attachment_52942" align="aligncenter" width="740"]

AMD[/caption]

AMD[/caption][caption id="attachment_52943" align="aligncenter" width="740"]

AMD[/caption]

AMD[/caption]“有了MI300X,你可以减少GPU的数量,随着模型规模的不断增长,这将变得更加重要。”

“有了更多的内存容量,更多的内存带宽,以及更少的GPU需求,我们可以在每个GPU上运行比以前更多的推理工作,"Su说。她说,这将降低大型语言模型的总拥有成本,使该技术更容易获得。

为了与英伟达的DGX系统竞争,Su推出了一系列人工智能计算机,即“AMD Instinct Platform”。第一个例子是将8台MI300X与1.5 TB的HMB3内存相结合。该服务器符合行业标准开放计算平台规范。

Su表示,“对于客户来说,他们可以在标准行业平台中使用所有这些内存中的AI计算能力,并直接投入到他们现有的基础设施中。”

[caption id="attachment_52944" align="aligncenter" width="740"]

AMD[/caption]

AMD[/caption]与MI300X不同,MI300A只是一个GPU,现有的MI300A将与英伟达的Grace Hopper组合芯片竞争,后者使用英伟达的Grace CPU和Hopper GPU,该公司上个月宣布该芯片已全面投入生产。

Su指出,MI300A正在被纳入能源部劳伦斯利弗莫尔国家实验室建造的El Capitan超级计算机中。

Su说,MI300A目前正作为样品向AMD客户展示,MI300X将于今年第三季度开始向客户提供样品。她说,这两款产品都将于第四季度批量生产。

来源:https://www.zdnet.com/article/amd-unveils-mi300x-ai-chip-as-generative-ai-accelerator/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消