能读取视频中人物唇语的人工智能

2019年12月05日 由 TGS 发表

156849

0

2016年,谷歌和牛津大学的研究人员详细介绍了一个系统,该系统能够以46.8%的准确率,标注视频片段,实测超过了专业唇读器12.4%的准确率。但是,即使是最先进的系统也很难克服嘴唇动作的模糊性,基于此,它们的表现根本无法超越基于音频的语音识别。

2016年,谷歌和牛津大学的研究人员详细介绍了一个系统,该系统能够以46.8%的准确率,标注视频片段,实测超过了专业唇读器12.4%的准确率。但是,即使是最先进的系统也很难克服嘴唇动作的模糊性,基于此,它们的表现根本无法超越基于音频的语音识别。为了开发更高效的语言识别系统,阿里巴巴、浙江大学和史蒂文斯理工学院的研究人员设计了一种被称为LIBS的方法,和其他类似的解决方案一样,LIBS可以帮助那些听力差的人跟踪缺少字幕的视频。

据估计,全世界有4.66亿人患有致残性耳聋,约占世界人口的5%。根据世界卫生组织的数据,到2050年,这一数字可能会增加到9亿多人。而换种思路想想,它也是外语不好的剧迷福音,在它的帮助下,外语不好的人完全可以独自在外网看喜欢的电影或电视剧。

LIBS从多尺度(包括序列级、上下文级和帧级)的说话人视频中提取有用的音频信息。然后,它通过识别这些数据与视频数据之间的对应关系(由于不同的采样率和有时出现在开始或结束处的空白,视频和音频序列具有不一致的长度)来将这些数据与视频数据对齐,并且利用滤波技术来细化提取的特征,进一步增加准确度。

LIBS从多尺度(包括序列级、上下文级和帧级)的说话人视频中提取有用的音频信息。然后,它通过识别这些数据与视频数据之间的对应关系(由于不同的采样率和有时出现在开始或结束处的空白,视频和音频序列具有不一致的长度)来将这些数据与视频数据对齐,并且利用滤波技术来细化提取的特征,进一步增加准确度。LIBS的语音识别器和唇读器组件,主要依靠一种基于注意力的序列到序列的体系结构,这是一种映射序列输入的机器翻译方法。研究人员对模型进行了训练,内容主要来自BBC的45000个口语句子,以及CMLR——中国最大的普通话唇读语料库,其中有来自中国网络电视网站的10万多个自然句(包括3000多个汉字和2万个短语)。

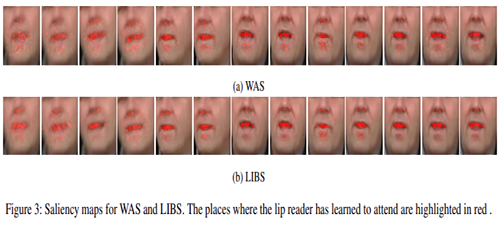

在训练过程中,该小组注意到,由于一些句子很短,模型很难在LRS2数据集上获得“合理”的结果,原因是解码器很难从少于14个字符的句子中提取相关信息。另一方面,如果对最长为16个单词的句子进行预训练,那么解码器就会利用上下文级别的知识,提高LRS2数据集中句子结尾部分的质量。对于这两种出乎意料的情况,研究人员在一篇描述他们工作的论文中写道:“前者可能是因为,LIBS减少了对无关帧的关注。后者则很有可能是框架级的知识提取,进一步提高了视频框架特征的可辨别力,使其注意力更加集中。”

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

下一篇

谁一眼发现了潜逃20年的劳荣枝?

热门企业

热门职位

写评论取消

回复取消