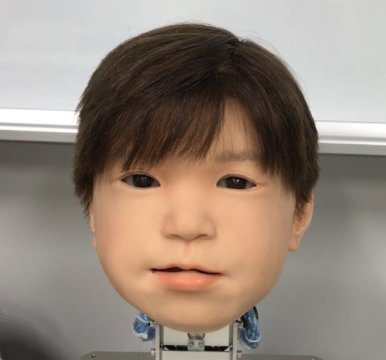

“安卓男孩”可以体现丰富的表情

2018年12月18日 由 yining 发表

523875

0

如果机器人更有效地与人类互动,机器人面孔必须表达更丰富的情感。日前研究人员解决了这一挑战,他们升级了他们的安卓机器人,名为Affetto。他们精确地检查了Affetto的面部点以及实现更像人类运动所需的不同力的精确平衡。通过机械测量和数学建模,他们能够利用他们的发现大大增强Affetto的情感表达范围。

日本对机器人的喜爱已不是秘密。现在,我们离让机器人有更多的面部表情进行交流又近了一步。

虽然机器人已经在日本的医疗、工业和其他领域取得了长足的进步,但在机器人脸上捕捉人性化的表情仍然是一个难以捉摸的挑战。虽然它们的系统特性已经得到了普遍的解决,但是机器人的面部表情还没有得到详细的研究。这是由于人类自然的面部运动范围大,不对称,机器人皮肤使用材料的限制,当然还有驱动机器人运动的复杂的工程和数学。

大阪大学的三名研究人员现在发现了一种识别和定量评估机器人儿童头部面部运动的方法。在2011年的一份出版物中,安卓的第一代机型被命名为Affetto。研究人员现已发现一种使第二代Affetto更具表现力的系统。他们的发现为机器人表达更大范围的情感提供了一个途径,并最终与人类有更深的互动。

研究人员在《机器人与人工智能的前沿》杂志上发表了他们的发现。

研究合著者Minoru Asada解释说:“表面变形是控制机器人表面的关键问题。”他们柔软的面部皮肤的运动会造成不稳定,这是我们要处理的一个大的硬件问题。我们寻求更好的方法来测量和控制它。”

研究人员调查了Affetto上116个不同的面部点,以测量其三维运动。面部点由所谓的变形单元支撑。每一个单元都由一系列的机械装置组成,这些机械装置可以产生一种独特的面部扭曲,如嘴唇或眼睑的部分下垂或隆起。然后将这些测量结果应用于一个数学模型,以量化它们的表面运动模式。

研究报告的第一作者石原慎太郎(Hisashi Ishihara)说:“安卓机器人的面孔一直是一个‘黑匣子’问题:它们已经被实现,但只是被模糊和笼统地评判了一下。”“我们的精确发现将让我们有效地控制机器人的面部动作,从而引入更多微妙的表情,比如微笑和皱眉。”

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

下一篇

计算机芯片漏洞被发现

热门企业

热门职位

写评论取消

回复取消