小测试:KNN算法的基础知识

2017年09月12日 由 xiaoshan.xiang 发表

968872

0

问题与答案

1)[正确或错误]:K - NN算法在测试时间上做的计算比训练时间多。

A)正确

B)错误

答案:A

该算法的训练阶段只包括存储训练样本的特征向量和类标签。

在测试阶段,测试点是通过分配在离该查询点最近的K训练样本中最频繁的标签进行分类的,因此需要更高的计算。

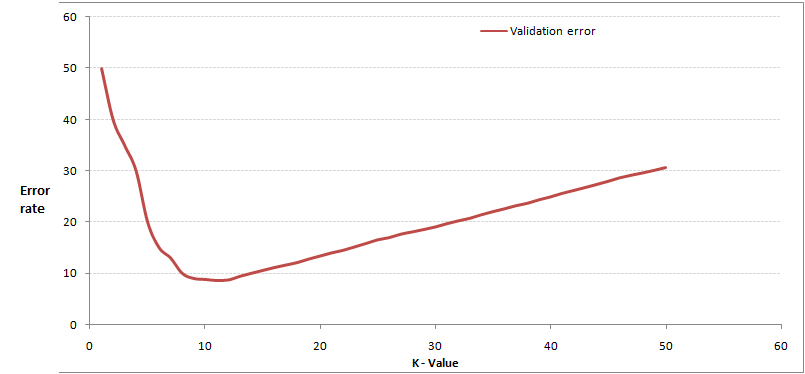

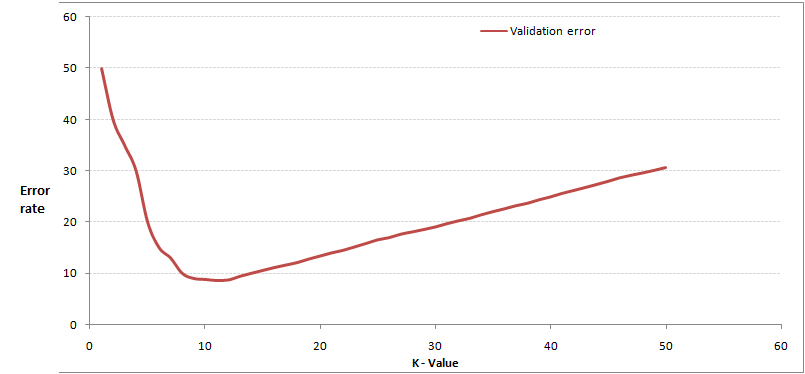

2)观察下面的图像,如果你使用K-Nearest Neighbor算法,下面哪一个是K的最佳值。

A)3

B)10

C)20

D)50

答案:B

当K值为10时,验证误差是最小的。

3)以下哪个距离度量不能在K - NN算法中使用?

F)以上全部

答案:F

所有这些距离度量可以作为K - NN算法的距离度量。

4)关于K - NN算法,下列哪个选项是正确的?

A)它可以用于分类

B)它可以用于回归

C)可以在分类和回归中使用

答案:C

我们也可以在回归问题中使用K - NN算法。在这种情况下,预测可以基于K - most相似实例中的平均值或中位数。

5)关于K - NN算法,下列哪个陈述是正确的?

A)1和2

B)1和3

C)只有1

D)以上全部

答案:D

以上叙述均是KNN算法的假设。

6)下列哪一种机器学习算法可用于估算分类和连续变量的缺失值?

B)线性回归

C)逻辑回归

答案:A

K - NN算法可以用于分类和连续变量的缺失值。

7)关于曼哈顿距离,下面哪一个是正确的?

A)它可以用于连续变量

B)可以用于分类变量

C)它可用于分类和连续

D)以上全部

答案:A

曼哈顿距离是为计算实值特征之间的距离而设计的。

8)在K - NN算法中,我们使用了以下哪个距离度量方法?

汉明距离

欧氏距离

曼哈顿距离

1)1

B)2

C)3

D)1和2

E)2和3

F)1、2和3

答案:A

欧几里得和曼哈顿距离用于连续变量,而汉明距离用于分类变量。

9)下面哪个选项是数据点A(1,3)和B(2,3)之间的欧氏距离?

1)1

B)2

C)4

D)8

答案:

sqrt( (1-2)^2 + (3-3)^2) = sqrt(1^2 + 0^2) = 1

10)以下哪项将是数据点A(1,3)和B(2,3)之间的曼哈顿距离?

1)1

B)2

C)4

D)8

答案:A

sqrt( mod((1-2)) + mod((3-3))) = sqrt(1 + 0) = 1

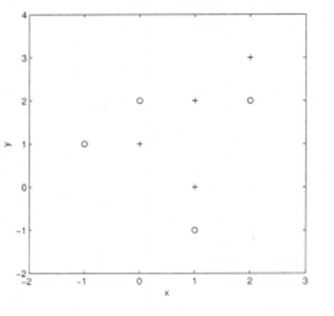

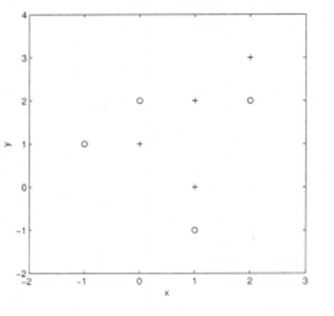

11 - 12题材料

假设,已经给出了数据,其中x和y是两个输入值,而类是因变量。

下面是述数据在2D空间中显示上的散点图。

11)假设,你想要使用3-nn中的欧式距离来预测新数据点x=1和y=1的类。这个数据点属于哪个类?

A)+类

B)-类

C)不确定

D)以上全部

答案:A

三个最近的点都是+类,所以这个点将被分类为+类。

12)在前面的问题中,你需要使用7 - NN而不是3 - KNN,那么x = 1和y = 1将属于哪类?

A)+类

B)-类

C)不确定

答案:B

现在这个点将被分类为-类,因为在最近的范围内有4个-类和3个+类点。

13)关于K - NN算法的偏差,下面哪个选项是正确的?

A)当你增加K时,偏差将增加

B)当你减少K时,偏差将增加

C)不确定

D)以上都不是

答案:A

较大的K值代表简单模型,简单模型总是作为高偏差的条件

14)关于K - NN的方差,下面哪个选项是正确的?

A)当你增加K时,方差会增加

B)当你减少K时,方差会增加

C)不确定

D)以上都不是

答案:B

简单模型将被认为是较小的方差模型

15)下面的两个距离(欧氏距离和曼哈顿距离)表明了K-NN算法使用的一般情况。这些距离为A(x1,y1)和B(x2,Y2)两点之间的距离。

你的任务是通过查看以下两个图来标记这两个距离。下面哪个选项是正确的?

A)左边是曼哈顿距离,右边是欧氏距离

B)左边是欧氏距离,右边是曼哈顿距离

C)左或右都不是曼哈顿的距离

D)左或右都是欧氏距离

答案:B

左边是欧氏距离的图形描述,而右边的是曼哈顿距离。

16)当你在K - NN算法的数据中发现噪音时,你会在考虑下列哪个选项?

A)增加K的值

B)降低K的值

C)噪声与K值无关

D)以上都不是

答案:A

为了更加确定你所做的分类,你可以尝试增加K的值。

17)在K - NN算法中,由于维数灾难,它很有可能被过度拟合。你认为以下哪一个选项可以处理这样的问题?

1.降维

2.特征选择

1)1

B)2

C)1和2

D)以上都不是

答案:C

在这种情况下,你可以使用维数减少算法或特征选择算法

18)以下是两份声明。下面哪个选项是正确的?

1.K - NN是一种基于记忆的方法,即当我们收集新的训练数据时,分类器会立即适应。

2.在最坏的情况下,新样本分类的计算复杂度与训练数据集中的样本数目线性增长。

1)1

B)2

C)1和2

D)以上都不是

答案:C

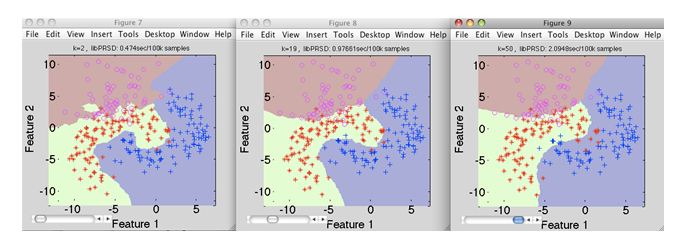

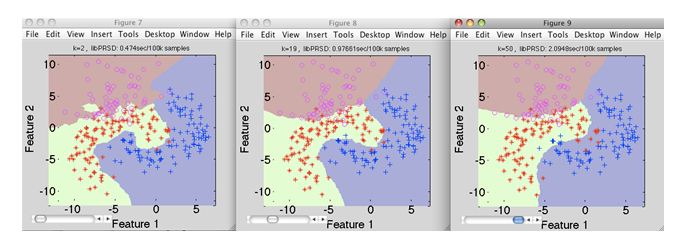

19)假设给出了下面的图像(1左2中3右),现在你的任务是找出每个图像中的K值,。

A)K1 > K2 > K3

B)K1 < K2

C)K1 = K2 = K3

D)以上都不是

答案:D

K的值在K3中是最高的,而在K1中是最低的

20)一个公司已经建立了一个KNN分类器,它在训练数据上的准确性达到100%。但当他们在客户端上部署这个模型时,发现这个模型根本不准确。以下哪一项可能出错?

注意:模型已经成功部署,客户端除了模型性能之外没有发现任何技术问题

A)这可能是一个过度拟合的模型

B)它可能是一个拟合不充分的模型

C)不确定

D)以上都不是

答案:A

在一个过度拟合的模块中,它在训练数据上表现良好,但不足够通用化,不能在新数据上给出相同的结果。

21)关于K - NN分类器下面哪个选项是正确的?

A)K值越大,分类精度越好

B)K值越小,决策边界越平滑

C)决策边界是线性的

D)K - NN不需要明确的训练步骤

答案:D

选项A:这并不总是正确的。你必须确保K值不是太高也不是太低。

选项B:这个说法不正确。决策边界可以有点锯齿

选项C:与选项B相同

选项D:这个陈述是正确的

22)[正确或错误]:通过使用1 - NN分类器,可以构建一个2 - NN分类器吗?

A)正确

B)错误

答案:A

你可以通过一个1 - NN分类器来实现一个2 - NN分类器

23)在K - NN算法中,当增加/减少K的值时会发生什么?

A)随着K值增加,决策边界变平滑

B)随着K值减小,决策边界变平滑

C)决策边界平滑度与K值无关

D)以上都不是

答案:A

通过增加K的值,决策边界会更平滑

24)以下是关于K - NN 算法的两个叙述,哪个叙述是正确的?

1.在交叉验证的帮助下,我们可以选择K的最优值

2.欧氏距离把每个特征都视为同等重要

A)1

B)2

C)1和2

D)以上都不是

答案:C

两种说法都是正确的

25 - 26题材料

假设,你已经训练了K - NN模型,现在你想要得到关于测试数据的预测。在得到预测结果之前,你需要计算K - NN预测测试数据所需的时间。

注:计算两个观测值之间的距离所需时间为D。

26)如果在测试数据中有N(非常大)个的观察报告,那么1 - NN需要的时间是多少?

A)N * D

B)N * D * 2

C)(N * D)/ 2

D)以上都不是

答案:A

N的值很大,所以选项A是正确的

27)1 - NN,2 - NN,3 - NN的时间之间的关系是什么?

A)1-NN > 2-NN > 3-NN

B)1 - NN < 2 - NN < 3 - NN

C)1 - NN ~ 2 - NN ~ 3 - NN

D)以上都不是

答案:C

在KNN算法中,K值的训练时间是相同的。

1)[正确或错误]:K - NN算法在测试时间上做的计算比训练时间多。

A)正确

B)错误

答案:A

该算法的训练阶段只包括存储训练样本的特征向量和类标签。

在测试阶段,测试点是通过分配在离该查询点最近的K训练样本中最频繁的标签进行分类的,因此需要更高的计算。

2)观察下面的图像,如果你使用K-Nearest Neighbor算法,下面哪一个是K的最佳值。

A)3

B)10

C)20

D)50

答案:B

当K值为10时,验证误差是最小的。

3)以下哪个距离度量不能在K - NN算法中使用?

- A) Manhattan

- B) MinKowsKi

- C) Tanimoto

- D) Jaccard

- E) Mahalanobis

F)以上全部

答案:F

所有这些距离度量可以作为K - NN算法的距离度量。

4)关于K - NN算法,下列哪个选项是正确的?

A)它可以用于分类

B)它可以用于回归

C)可以在分类和回归中使用

答案:C

我们也可以在回归问题中使用K - NN算法。在这种情况下,预测可以基于K - most相似实例中的平均值或中位数。

5)关于K - NN算法,下列哪个陈述是正确的?

- 如果所有的数据都有相同的大小,K- NN算法会做得更好

- K- NN算法可以很好地处理少量的输入变量(p),但是当输入的数量非常大时就会陷入困境。

- K- NN算法对解决问题的函数形式没有任何假设。

A)1和2

B)1和3

C)只有1

D)以上全部

答案:D

以上叙述均是KNN算法的假设。

6)下列哪一种机器学习算法可用于估算分类和连续变量的缺失值?

- A) K-NN

B)线性回归

C)逻辑回归

答案:A

K - NN算法可以用于分类和连续变量的缺失值。

7)关于曼哈顿距离,下面哪一个是正确的?

A)它可以用于连续变量

B)可以用于分类变量

C)它可用于分类和连续

D)以上全部

答案:A

曼哈顿距离是为计算实值特征之间的距离而设计的。

8)在K - NN算法中,我们使用了以下哪个距离度量方法?

汉明距离

欧氏距离

曼哈顿距离

1)1

B)2

C)3

D)1和2

E)2和3

F)1、2和3

答案:A

欧几里得和曼哈顿距离用于连续变量,而汉明距离用于分类变量。

9)下面哪个选项是数据点A(1,3)和B(2,3)之间的欧氏距离?

1)1

B)2

C)4

D)8

答案:

sqrt( (1-2)^2 + (3-3)^2) = sqrt(1^2 + 0^2) = 1

10)以下哪项将是数据点A(1,3)和B(2,3)之间的曼哈顿距离?

1)1

B)2

C)4

D)8

答案:A

sqrt( mod((1-2)) + mod((3-3))) = sqrt(1 + 0) = 1

11 - 12题材料

假设,已经给出了数据,其中x和y是两个输入值,而类是因变量。

下面是述数据在2D空间中显示上的散点图。

11)假设,你想要使用3-nn中的欧式距离来预测新数据点x=1和y=1的类。这个数据点属于哪个类?

A)+类

B)-类

C)不确定

D)以上全部

答案:A

三个最近的点都是+类,所以这个点将被分类为+类。

12)在前面的问题中,你需要使用7 - NN而不是3 - KNN,那么x = 1和y = 1将属于哪类?

A)+类

B)-类

C)不确定

答案:B

现在这个点将被分类为-类,因为在最近的范围内有4个-类和3个+类点。

13)关于K - NN算法的偏差,下面哪个选项是正确的?

A)当你增加K时,偏差将增加

B)当你减少K时,偏差将增加

C)不确定

D)以上都不是

答案:A

较大的K值代表简单模型,简单模型总是作为高偏差的条件

14)关于K - NN的方差,下面哪个选项是正确的?

A)当你增加K时,方差会增加

B)当你减少K时,方差会增加

C)不确定

D)以上都不是

答案:B

简单模型将被认为是较小的方差模型

15)下面的两个距离(欧氏距离和曼哈顿距离)表明了K-NN算法使用的一般情况。这些距离为A(x1,y1)和B(x2,Y2)两点之间的距离。

你的任务是通过查看以下两个图来标记这两个距离。下面哪个选项是正确的?

A)左边是曼哈顿距离,右边是欧氏距离

B)左边是欧氏距离,右边是曼哈顿距离

C)左或右都不是曼哈顿的距离

D)左或右都是欧氏距离

答案:B

左边是欧氏距离的图形描述,而右边的是曼哈顿距离。

16)当你在K - NN算法的数据中发现噪音时,你会在考虑下列哪个选项?

A)增加K的值

B)降低K的值

C)噪声与K值无关

D)以上都不是

答案:A

为了更加确定你所做的分类,你可以尝试增加K的值。

17)在K - NN算法中,由于维数灾难,它很有可能被过度拟合。你认为以下哪一个选项可以处理这样的问题?

1.降维

2.特征选择

1)1

B)2

C)1和2

D)以上都不是

答案:C

在这种情况下,你可以使用维数减少算法或特征选择算法

18)以下是两份声明。下面哪个选项是正确的?

1.K - NN是一种基于记忆的方法,即当我们收集新的训练数据时,分类器会立即适应。

2.在最坏的情况下,新样本分类的计算复杂度与训练数据集中的样本数目线性增长。

1)1

B)2

C)1和2

D)以上都不是

答案:C

19)假设给出了下面的图像(1左2中3右),现在你的任务是找出每个图像中的K值,。

A)K1 > K2 > K3

B)K1 < K2

C)K1 = K2 = K3

D)以上都不是

答案:D

K的值在K3中是最高的,而在K1中是最低的

20)一个公司已经建立了一个KNN分类器,它在训练数据上的准确性达到100%。但当他们在客户端上部署这个模型时,发现这个模型根本不准确。以下哪一项可能出错?

注意:模型已经成功部署,客户端除了模型性能之外没有发现任何技术问题

A)这可能是一个过度拟合的模型

B)它可能是一个拟合不充分的模型

C)不确定

D)以上都不是

答案:A

在一个过度拟合的模块中,它在训练数据上表现良好,但不足够通用化,不能在新数据上给出相同的结果。

21)关于K - NN分类器下面哪个选项是正确的?

A)K值越大,分类精度越好

B)K值越小,决策边界越平滑

C)决策边界是线性的

D)K - NN不需要明确的训练步骤

答案:D

选项A:这并不总是正确的。你必须确保K值不是太高也不是太低。

选项B:这个说法不正确。决策边界可以有点锯齿

选项C:与选项B相同

选项D:这个陈述是正确的

22)[正确或错误]:通过使用1 - NN分类器,可以构建一个2 - NN分类器吗?

A)正确

B)错误

答案:A

你可以通过一个1 - NN分类器来实现一个2 - NN分类器

23)在K - NN算法中,当增加/减少K的值时会发生什么?

A)随着K值增加,决策边界变平滑

B)随着K值减小,决策边界变平滑

C)决策边界平滑度与K值无关

D)以上都不是

答案:A

通过增加K的值,决策边界会更平滑

24)以下是关于K - NN 算法的两个叙述,哪个叙述是正确的?

1.在交叉验证的帮助下,我们可以选择K的最优值

2.欧氏距离把每个特征都视为同等重要

A)1

B)2

C)1和2

D)以上都不是

答案:C

两种说法都是正确的

25 - 26题材料

假设,你已经训练了K - NN模型,现在你想要得到关于测试数据的预测。在得到预测结果之前,你需要计算K - NN预测测试数据所需的时间。

注:计算两个观测值之间的距离所需时间为D。

26)如果在测试数据中有N(非常大)个的观察报告,那么1 - NN需要的时间是多少?

A)N * D

B)N * D * 2

C)(N * D)/ 2

D)以上都不是

答案:A

N的值很大,所以选项A是正确的

27)1 - NN,2 - NN,3 - NN的时间之间的关系是什么?

A)1-NN > 2-NN > 3-NN

B)1 - NN < 2 - NN < 3 - NN

C)1 - NN ~ 2 - NN ~ 3 - NN

D)以上都不是

答案:C

在KNN算法中,K值的训练时间是相同的。

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消