如何检测 Deepfakes和其他AI媒体生成的虚假信息

2023年05月19日 由 daydream 发表

930683

0

我们正处在一个制造虚假信息变得越来越容易的时代。Deepfakes、Stable Diffusion、生成对抗网络(GAN)和许多其他人工智能技术使得用户可以操纵照片和视频,或者创建从未发生过的事件。

虽然人工智能生成的艺术和媒体有许多积极的应用,但它们也可能被恶意利用。凭借无缝操纵和扭曲现实的能力,不良行为者可以利用人工智能欺骗公众并传播错误信息。

在这篇文章中,我将简要探讨Deepfakes的威胁,并提供一些检测人工智能生成虚假信息的技巧。这个领域正在迅速发展,所以你必须寻找新的技术和对策。

AI生成的虚假信息

穿着羽绒服的教皇等事件虽然都没有发生,但他们的图像和视频已经在社交媒体上流传。

目前,有几种深度学习技术可以创造虚假信息:

– Deepfakes:Deepfakes使用两个深度神经网络来学习演员和目标的面部特征。然后,它将目标的脸映射到演员的头上。使用算法让它们的输出变得非常令人信服和逼真。根据ExpressVPN的数据,互联网上可用的Deepfakes数量以百万计,而且这个数字没有减少的迹象。

– Diffusion 模型:这些神经网络是在大量的图像和字幕数据集上训练出来的。通过查找将文本连接到图像的模式,这些模型可以从文本描述中生成令人信服的图像。DALL-E 2、Midjourney和Stable Diffusion是流行Diffusion模型的三个例子。

– 生成对抗网络(GAN):GAN 是深度学习系统,可以从头开始创建逼真的图像,例如人脸和风景。

AI生成的潜在危害

Deepfakes已经存在了好几年。而该领域在过去几年中取得了令人印象深刻的进展。与其他生成式人工智能技术(如语音合成器和大型语言模型)一起,人工智能生成的内容可能会成为真正的威胁。

虽然我们仍处于可以检测人工智能生成媒体的阶段,但更值得注意的是它们如何影响公众舆论:

– 错误信息的传播:图像和视频在社交媒体上的传播速度非常快。当事实核查员或生成式AI有时间对目标做出反应时,损害可能已经造成。特别是当Deepfakes的创建者可以将它们与逼真的 AI 生成的声音相结合时,它们会变得非常有说服力。

– 曼德拉效应:很多人都记得上世纪80年代纳尔逊·曼德拉死于南非监狱的一件事。实际上,他于1990年从监狱获释,后来成为南非总统。但是,即使事实是显而易见的,但这个虚假的故事已经在许多人的脑海中根深蒂固。这就是众所周知的“曼德拉效应”,还有许多其他的例子被记录下来。而有了Deepfakes,这样的问题可能会更频繁地出现。

– 社会工程:Deepfakes和生成式 AI 让制作出令人信服的电子邮件、视频、网站等以及进行网络钓鱼活动变得更加容易。不良行为者可以使用这些模型来创建逼真的头像、制作专业电子邮件以及创建听起来像真人的语音消息。他们可以利用这些数据来欺骗受害者泄露秘密、向攻击者汇款或进行其他有害活动。去年,有人曝光了一家假律师事务所,该律师事务所使用生成式人工智能通过DMCA勒索受害者。

– 信任的削弱:Deepfakes的兴起将使人们更难相信他们看到的任何东西。确定什么是真的,什么是假的将变得越来越困难。一方面,不良行为者会试图用生成式人工智能歪曲真相。另一方面,他们可能会否认真实的证据,并声称真实的文件和视频是由人工智能生成的。

如何检测 AI 生成的虚假信息

研究人员不断创造新的技术和工具来检测由Deepfakes和其他人工智能系统生成的图像和视频。但这是一场猫捉老鼠的游戏,随着技术的进步,旧的检测技术已经过时了。目前,这里有一些关键方法可以帮助你检测Deepfakes视频、GAN 人脸和Diffusion模型生成的图像:

– 面部失真:Deepfakes和 GAN 生成的人脸通常在整个表面上的光照不一致。你还可以在细节和边缘所在的位置找到扭曲变形。特别注意发际线、眉毛、面部毛发、耳环,尤其是眼镜边框。

– 眼睛和嘴唇运动:在 Deepfake 视频中,要特别注意脸部的活动部位。阴影是否一致?眨眼看起来逼真吗?受试者说话时,嘴巴和牙齿看起来自然吗?

– 照明和反射:生成模型尝试预测场景中的照明。当然,并非所有的预测都是正确的,所以如果你仔细观察,你会发现阴影和反射偶尔会出现故障。这些都是人工智能生成图像的迹象。

–比例:Diffusion模型生成的图像通常比例错误,例如手臂、脚、前臂等长度错误。这些一开始可能不明显,但仔细观察会很快发现人工智能生成的图像。

– 目标细节:当前的生成模型在组合性和目标细节方面尤其糟糕。看看诸如手,建筑物,带有许多零件的物体之类的东西。图像的背景通常会包含一些明显的错误。

–来源:当然,检测Deepfakes和人工智能生成的图像的重要方法之一是验证其来源。在Google或Bing上进行反向图像搜索,查看该图像是否在社交媒体以外的任何地方出现。查看是否有任何信誉良好的媒体报道了这一事件。如果照片更私人,与朋友或家人有关,请在相信你的眼睛之前直接与他们核实。

虽然人工智能生成的艺术和媒体有许多积极的应用,但它们也可能被恶意利用。凭借无缝操纵和扭曲现实的能力,不良行为者可以利用人工智能欺骗公众并传播错误信息。

在这篇文章中,我将简要探讨Deepfakes的威胁,并提供一些检测人工智能生成虚假信息的技巧。这个领域正在迅速发展,所以你必须寻找新的技术和对策。

AI生成的虚假信息

穿着羽绒服的教皇等事件虽然都没有发生,但他们的图像和视频已经在社交媒体上流传。

目前,有几种深度学习技术可以创造虚假信息:

– Deepfakes:Deepfakes使用两个深度神经网络来学习演员和目标的面部特征。然后,它将目标的脸映射到演员的头上。使用算法让它们的输出变得非常令人信服和逼真。根据ExpressVPN的数据,互联网上可用的Deepfakes数量以百万计,而且这个数字没有减少的迹象。

– Diffusion 模型:这些神经网络是在大量的图像和字幕数据集上训练出来的。通过查找将文本连接到图像的模式,这些模型可以从文本描述中生成令人信服的图像。DALL-E 2、Midjourney和Stable Diffusion是流行Diffusion模型的三个例子。

– 生成对抗网络(GAN):GAN 是深度学习系统,可以从头开始创建逼真的图像,例如人脸和风景。

AI生成的潜在危害

Deepfakes已经存在了好几年。而该领域在过去几年中取得了令人印象深刻的进展。与其他生成式人工智能技术(如语音合成器和大型语言模型)一起,人工智能生成的内容可能会成为真正的威胁。

虽然我们仍处于可以检测人工智能生成媒体的阶段,但更值得注意的是它们如何影响公众舆论:

– 错误信息的传播:图像和视频在社交媒体上的传播速度非常快。当事实核查员或生成式AI有时间对目标做出反应时,损害可能已经造成。特别是当Deepfakes的创建者可以将它们与逼真的 AI 生成的声音相结合时,它们会变得非常有说服力。

– 曼德拉效应:很多人都记得上世纪80年代纳尔逊·曼德拉死于南非监狱的一件事。实际上,他于1990年从监狱获释,后来成为南非总统。但是,即使事实是显而易见的,但这个虚假的故事已经在许多人的脑海中根深蒂固。这就是众所周知的“曼德拉效应”,还有许多其他的例子被记录下来。而有了Deepfakes,这样的问题可能会更频繁地出现。

– 社会工程:Deepfakes和生成式 AI 让制作出令人信服的电子邮件、视频、网站等以及进行网络钓鱼活动变得更加容易。不良行为者可以使用这些模型来创建逼真的头像、制作专业电子邮件以及创建听起来像真人的语音消息。他们可以利用这些数据来欺骗受害者泄露秘密、向攻击者汇款或进行其他有害活动。去年,有人曝光了一家假律师事务所,该律师事务所使用生成式人工智能通过DMCA勒索受害者。

– 信任的削弱:Deepfakes的兴起将使人们更难相信他们看到的任何东西。确定什么是真的,什么是假的将变得越来越困难。一方面,不良行为者会试图用生成式人工智能歪曲真相。另一方面,他们可能会否认真实的证据,并声称真实的文件和视频是由人工智能生成的。

如何检测 AI 生成的虚假信息

研究人员不断创造新的技术和工具来检测由Deepfakes和其他人工智能系统生成的图像和视频。但这是一场猫捉老鼠的游戏,随着技术的进步,旧的检测技术已经过时了。目前,这里有一些关键方法可以帮助你检测Deepfakes视频、GAN 人脸和Diffusion模型生成的图像:

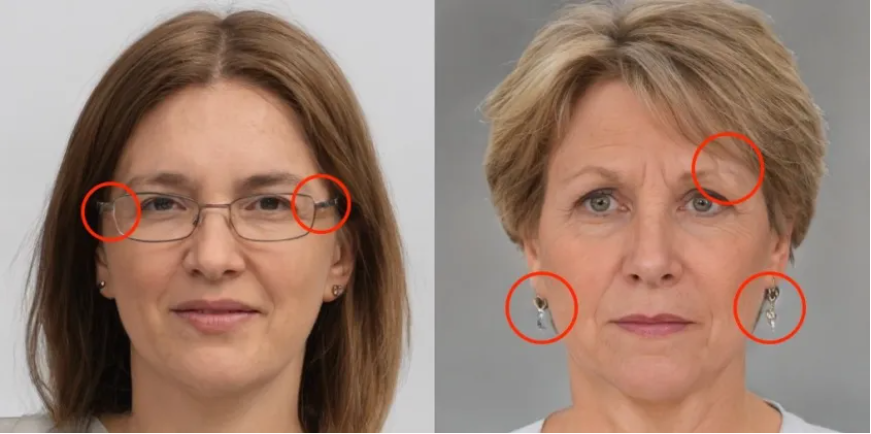

– 面部失真:Deepfakes和 GAN 生成的人脸通常在整个表面上的光照不一致。你还可以在细节和边缘所在的位置找到扭曲变形。特别注意发际线、眉毛、面部毛发、耳环,尤其是眼镜边框。

GAN面部有清晰可见的伪像

– 眼睛和嘴唇运动:在 Deepfake 视频中,要特别注意脸部的活动部位。阴影是否一致?眨眼看起来逼真吗?受试者说话时,嘴巴和牙齿看起来自然吗?

– 照明和反射:生成模型尝试预测场景中的照明。当然,并非所有的预测都是正确的,所以如果你仔细观察,你会发现阴影和反射偶尔会出现故障。这些都是人工智能生成图像的迹象。

–比例:Diffusion模型生成的图像通常比例错误,例如手臂、脚、前臂等长度错误。这些一开始可能不明显,但仔细观察会很快发现人工智能生成的图像。

– 目标细节:当前的生成模型在组合性和目标细节方面尤其糟糕。看看诸如手,建筑物,带有许多零件的物体之类的东西。图像的背景通常会包含一些明显的错误。

–来源:当然,检测Deepfakes和人工智能生成的图像的重要方法之一是验证其来源。在Google或Bing上进行反向图像搜索,查看该图像是否在社交媒体以外的任何地方出现。查看是否有任何信誉良好的媒体报道了这一事件。如果照片更私人,与朋友或家人有关,请在相信你的眼睛之前直接与他们核实。

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消