微软的新技术使面部动作与语音片段更好同步

2019年10月08日 由 TGS 发表

223966

0

越来越多的研究表明,只要有足够大的语料库,几乎任何人的面部动作都可以与语音片段同步。今年6月,三星(samsung)的应用科学家详细介绍了一种端到端的模型,该模型能够在人的头颅中对眉毛、嘴、睫毛和脸颊进行动画处理。仅仅几周后,Udacity发布了一个系统,该系统可以从音频叙述中自动生成独立演讲视频。

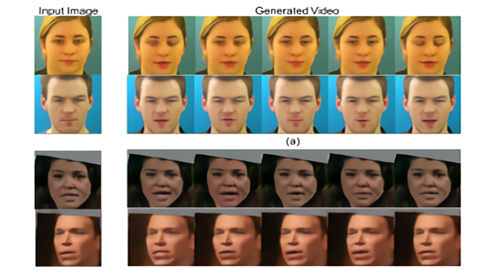

越来越多的研究表明,只要有足够大的语料库,几乎任何人的面部动作都可以与语音片段同步。今年6月,三星(samsung)的应用科学家详细介绍了一种端到端的模型,该模型能够在人的头颅中对眉毛、嘴、睫毛和脸颊进行动画处理。仅仅几周后,Udacity发布了一个系统,该系统可以从音频叙述中自动生成独立演讲视频。两年前,卡内基梅隆大学的研究人员发表了一篇论文,描述了一种将面部动作从一个人转移到另一个人的方法。在这项和其他工作的基础上,微软的一个研究小组本周提出了一项技术,他们声称这项技术可以提高音频驱动的头部动画的逼真度。

以前的头部人像生成方法需要干净的、相对无噪音的、带有中性色调的音频,但研究人员说,他们的方法可以将音频序列分解成语音内容和背景噪音等因素,从而推广到有噪音和“情感丰富”的数据样本:“众所周知,演讲充满了变化。不同的人在不同的语境中用不同的时间、幅度、语气等来表达同一个词。除了语言内容外,音声也承载着丰富的信息,揭示了说话人的情绪状态、身份和个性等。”

微软小组提出的技术,其基础是一个能学习潜在表示的变分自编码器(VAE)。输入的音频序列会被VAE分解成不同的表示形式,在输入音频的基础上,VAE会从分布中采样一个内容表示序列,该序列连同输入的人脸图像一起被馈送到视频生成器,以使人脸具有动画效果。

微软小组提出的技术,其基础是一个能学习潜在表示的变分自编码器(VAE)。输入的音频序列会被VAE分解成不同的表示形式,在输入音频的基础上,VAE会从分布中采样一个内容表示序列,该序列连同输入的人脸图像一起被馈送到视频生成器,以使人脸具有动画效果。研究人员选取了三个数据集来训练和测试VAE,分别是GRID、CREMA-D和LRS3。GRID是一个视听语料库,包含来自34个说话者的1000个录音; CREMA-D是由来自91位不同种族演员的7,442个表演片段组成的视频集; LRS3则是一个包含了超过10万TED视频中的口语句子的数据库。研究人员将网格和CREMA-D输入到模型中,教它识别语音和情感表征,然后使用一对定量指标(峰值信噪比(PSNR)和结构相似度指数(SSIM))来评估生成视频的质量。

该团队表示,就表现而言,他们的方法与其他中立的口语表达方法在所有指标上都是一样的。此外,他们注意到,“它”能够在整个情感光谱上持续表现,而且它与当前所有最先进的生成方法兼容。

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消