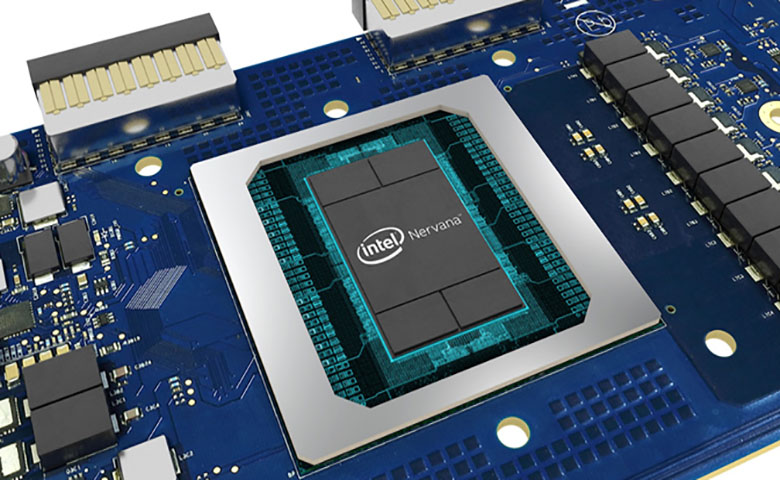

英特尔推出其Nervana推理和训练芯片,首款AI推理芯片基于10纳米技术

2019年08月22日 由 董灵灵 发表

89433

0

英特尔公布了其基于10纳米技术的AI处理器Spring Hill的细节,该处理器将首次采用AI技术,专为大型计算中心而设计,由以色列海法中心研发。

英特尔公布了其基于10纳米技术的AI处理器Spring Hill的细节,该处理器将首次采用AI技术,专为大型计算中心而设计,由以色列海法中心研发。芯片是该公司首款Nervana神经网络处理器(NPP)系列产品,其中一款将用于训练AI系统,而另一款则用于推理。它表示,Facebook已经开始使用该产品。

NNP-I 1000(Spring Hill)和NNP-T(Spring Crest)适用于两个不同的市场,训练和推理。

Spring Crest

代号为Spring Crest的Nervana NNP-T将用于训练,并配备24个Tensor处理集群,专门用于驱动神经网络。英特尔的新型片上系统(SoC)为用户提供了在专用硬件上训练AI系统所需的一切。

英特尔的Spring Crest NNP-T旨在扩展到前所未有的程度,在张量处理能力,封装HBM,网络功能和片上SRAM之间取得平衡,以提高处理性能。底层芯片由TSMC制造。

NNP-T设计用于在不需要底盘的情况下有效向外扩展。多个NNP-T加速器可以在同一个机箱中连接在一起,并且这些卡支持机箱到机箱甚至机架到机架的无缝连接,无需开关。每个夹层卡背面有四个QFSP(Quad Small Form Factor Pluggable)网络端口。

Spring Hill

代号为Spring Hill的Nervana NNP-I是该公司推出的SoC推理系统,利用其10纳米工艺技术和Ice Lake核心帮助用户部署训练过的人工智能系统。

在NNP-T设计用于150-250W功率包络的情况下,NNP-I是一个10-50W的部件,用于插入M.2插槽。它具有两个Ice Lake CPU内核和12个推理计算引擎(ICE)。

Spring Hill可以添加到任何支持M.2插槽的现代服务器中,根据英特尔的说法,该设备通过M.2提升器进行通信,就像PCIe产品而不是NVMe一样。

NNP-I的目标是在AI处理器上运行操作,同时减少系统中主CPU所需的开销。该器件通过PCIe连接(支持PCIe 3.0和4.0)并处理AI工作负载,使用片上Icelake内核进行任何必要的处理。片上SRAM和DRAM提供本地存储器带宽。

推理计算引擎支持各种指令格式,范围从FP16到INT1,每个ICE都有一个可编程矢量处理器和一个4MB SRAM。

推理计算引擎支持各种指令格式,范围从FP16到INT1,每个ICE都有一个可编程矢量处理器和一个4MB SRAM。NNP-I的整体内存子系统也进行了优化,英特尔声称,当以10W TDP运行时,NNP-I可以提供每秒3600次推理的ResNet50性能。这可达到4.8 TOPS /瓦,符合英特尔的整体效率目标(该公司声称NNP-I在低功率下效率最高)。

英特尔不希望NNP-I进入零售市场,但与高端数据中心训练解决方案相比,推理解决方案正在蓬勃发展。NNP-I可以在不久的将来向广泛的客户发货,具体取决于总体采用情况。

英特尔新推出的专注于人工智能的SoC旨在处理数据中心环境中的AI工作负载,这样用户就不必再使用其Xeon cpu来处理人工智能和机器学习任务。Xeon芯片能够处理这样的工作负载,尽管它们的效率或效率远远不如Xeon芯片。

Nervana NNP-T和NNP-I旨在与谷歌的Tensor Porcessing Unit竞争,Nvidia基于NVDLA的技术和亚马逊的AWS Inferentia芯片竞争。

英特尔人工智能产品集团副总裁兼总经理Naveen Rao解释说,该公司的新处理器将帮助推动人工智能无处不在的未来。

他表示,为了实现未来的AI无处不在的状态,我们需要解决所产生的数据压榨问题,并确保企业能够有效利用其数据,在有意义的情况下将数据收集起来,并使其更加智能化使用他们的上游资源。

数据中心和云需要访问高性能和可扩展的通用计算,以及复杂AI应用程序的专用加速。在未来的AI愿景中,需要采用整体方法,即从硬件到软件再到应用程序。

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消