MIT研究:在不影响准确度的情况下将神经网络缩小10倍

2019年05月07日 由 董灵灵 发表

822352

0

深度神经网络是一种通用类型的AI架构,能够执行从自然语言处理到计算机视觉的任务,但这并不意味着它们没有限制。

深度神经网络是一种通用类型的AI架构,能够执行从自然语言处理到计算机视觉的任务,但这并不意味着它们没有限制。深度神经网络通常非常庞大并且需要相应的大型语料库,即使是最昂贵的专用硬件,对它们进行训练也可能需要数天时间。

麻省理工学院计算机科学与人工智能实验室(CSAIL)发表了一项新研究,“The Lottery Ticket Hypothesis: Finding Sparse, Trainable Neural Networks”,论文中解释道,深度神经网络包含的子网比整个网络小10倍,但经过训练,它们能够做出同样精确的预测,在某些情况下比原始网络更快。

这项研究计划在新奥尔良举行的国际学习代表大会(ICLR)上发表,在大约1600份提交的论文中,它被列为会议的前两名论文之一。

如果初始网络没有那么大,为什么不能在一开始就创建一个大小合适的网络呢?通过神经网络,你可以随机初始化这个大型结构,并用大量数据进行训练之后,它就会神奇地起作用。

“这种大型结构就像购买很多彩票,即使只有少量彩票会让你变得富有。但是,我们仍然需要一种技术,在不先看到中奖号码的情况下找到赢家。”

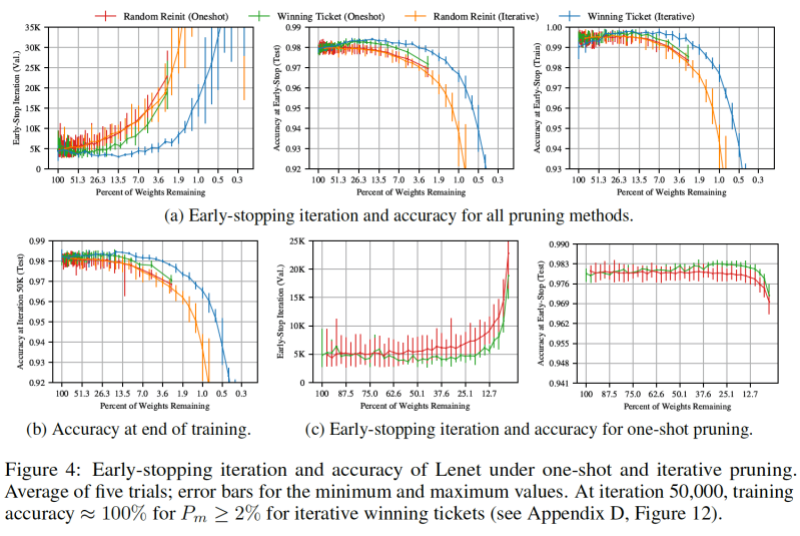

研究人员的方法涉及消除神经元之间不必要的连接,以使其适应低功率设备,这一过程通常称为修剪。他们特别选择了具有最低“权重”的连接,这表明它们是最不重要的。

接下来,他们在没有修剪连接的情况下训练网络并重置权重,在修剪其他连接后,他们确定了在不影响模型预测能力的情况下可以去除多少。

在一系列条件下,在不同网络上重复该过程数万次之后,团队报告说AI模型的规模始终比其完全连接的父网络的大小要小10%到20%。

Michael Carbin表示,“令人惊讶的是,重新设置一个表现良好的网络通常会带来更好的结果,这表明无论我们第一次做什么,都不是最完美的,这些模型还有空间来学习如何自行改进。”

Carbin和Frankle指出,他们只考虑以较小数据集为中心的以视觉为中心的分类任务。未来的研究将探讨为什么某些子网特别擅长学习,以及快速发现这些子网络的方法。

此外,他们认为结果可能对迁移学习有影响,即为一项任务训练的网络可以适应另一项任务。

论文:

arxiv.org/abs/1803.03635

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消