改变你对数据看法的五种机器学习悖论

2019年05月06日 由 董灵灵 发表

959464

0

悖论是人类认知的奇迹之一,很难用数学和统计学来解释。

悖论是人类认知的奇迹之一,很难用数学和统计学来解释。从概念上讲,悖论是一种基于问题的原始前提得出明显自相矛盾的结论的陈述。即使是最著名的悖论也经常愚弄领域专家,因为它们从根本上违背了常识。

由于人们希望人工智能重建人类的认知,机器学习模型在训练数据中遇到矛盾的模式,并得出乍一看似乎矛盾的结论,是非常常见的。

机器学习模型作为任何一种基于数据的知识构建形式,不能免除认知悖论。当机器学习试图推断隐藏在训练数据集中的模式,并根据特定的环境验证它们的知识时,它们总是很容易得出自相矛盾的结论。下面是机器学习解决方案中出现的一些最有名的悖论。

Simpson悖论

这一悖论以英国数学家Edward Simpson命名,描述了一种现象:有一个趋势是非常明显的,几个组的数据随着这些组中的数据的组合而消失。

1973年发生了一个真实的案例。伯克利大学研究生院对录取率进行了调查。这所大学因招生中的性别差异而被女性起诉。调查结果是:当每一所学校(法律、医学、工程等)分开来看时,女性的录取率高于男性,然而,平均来看,男性的录取率比女性高得多。这怎么可能?

对先前用例的解释是,简单平均值不考虑整个数据集内特定组的相关性。在这个具体的例子中,大量女性申请入学率低的学校:如法律和医学。这些学校录取的学生不到10%。因此,接受的女性比例非常低。另一方面,男性往往更多地申请入学率高的学校:与工程学一样,入学率约为50%。因此,接受的男性比例非常高。

在机器学习的背景下,许多无监督学习算法推断出不同训练数据集的模式,这些数据集在全面组合时会导致矛盾。

Braess悖论

这个悖论是由德国数学家Dietrich Braes于1968年提出的。使用拥挤的交通网络的例子,布拉斯解释说,与直觉相反,在道路网络中添加道路可能会阻碍其流动,例如每个司机的行驶时间,同样,关闭道路也有可能改善出行时间。

Braess推理的基础是,在nash均衡博弈中,司机没有改变路线的动机。从博弈论的角度来看,如果其他人坚持使用相同的策略,那么个体在使用新策略时就不会有任何收益。对于司机来说,策略是采取的路线。在布雷斯悖论的情况下,尽管整体性能下降,驾驶员仍将继续切换,直到达到nash均衡。因此,与直觉相反,关闭道路可能会缓解拥堵。

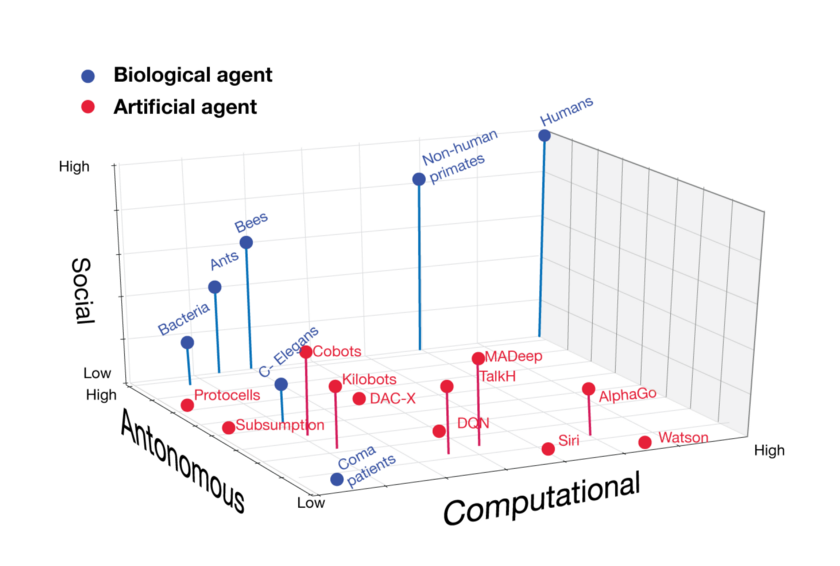

Braess悖论在自主的多智能体强化学习场景中很常见,其中模型需要基于未知环境中的特定决策来奖励代理。

Moravec悖论

Hans Moravec可以被认为是过去几十年来最伟大的AI思想家之一。在20世纪80年代,Moravec对AI模型获取知识的方式提出了一个反直觉的命题。

Moravec悖论指出,与普遍认为相反,高级推理需要的计算量低于低级无意识认知。这是一种经验观察,与更大的计算能力导致更智能的系统这一概念背道而驰。

构建Moravec悖论的一种更简单的方法是,AI模型可以完成非常复杂的统计和数据推理任务,这些任务对人类来说是不可能的。然而,许多对人类来说微不足道的任务就像抓住物体一样需要昂贵的AI模型。让计算机在智力测试或玩跳棋时表现出成人水平的表现相对容易,而且在感知和行动方面,甚至无法让它们达到儿童的技能水平。

从机器学习的角度来看,Moravec的悖论在转移学习方面非常适用,它可以在不同的机器学习模型中推广知识,而且机器智能的一些最佳应用将是人类和算法的结合。

准确性悖论

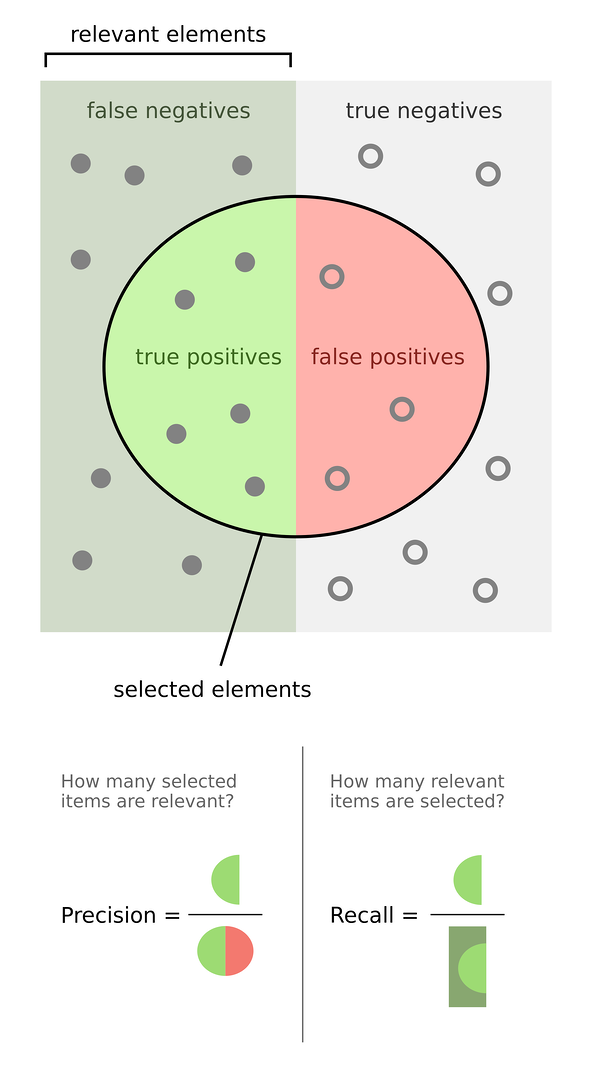

与机器学习直接相关的是,准确性悖论指出,准确性并不总是对预测模型的有效性进行分类的良好指标,根源在于不平衡的训练数据集。例如,在A类发生率占主导地位的数据集中,在99%的案例中都能被发现,然后就预测每个案例都是A类的准确率为99%,这完全是误导。

理解准确性悖论的一种更简单的方法是,在机器学习模型中找到准确率和召回率之间的平衡。在机器学习算法中,准确率通常被定义为测量正类的预测的哪个部分是有效的。它由(真阳性/真阳性+假阳性)确定。召回率指标衡量预测实际捕获正类的频率。它由(真阳性/真阳性+假阴性)表示。

在用于欺诈检测的算法的情况下,召回率是更重要的度量。抓住每一种可能的欺诈行为显然很重要,即使这意味着可能需要经历一些误报。另一方面,如果为情绪分析创建算法,并且你需要的只是在推文中指出的高级情感概念,那么目标是获得准确率。

Learnability-Godel悖论

这是一个最近才提出的悖论,悖论将机器学习模型的能力与最有争议的数学理论之一联系起来:哥德尔的不完备性定理。

1931年,哥德尔发表了他的两个不完备性定理,基本上说使用标准数学语言无法证明某些陈述是真是假。换句话说,数学是一种不足以理解宇宙某些方面的语言。这些定理被称为Gödel's continuum hypothesis。

以色列理工学院的AI研究人员将哥德尔的连续统假设与机器学习模型的可学习性联系起来。在一个挑战所有共同智慧的矛盾声明中,研究人员定义了可学习性概念的概念。

如果continuum hypothesis是真的,那么一个小样本就足以进行外推。但如果它是假的,那么没有一个有限的样本是足够的。通过这种方式,他们表明可学习性问题等同于continuum hypothesis。因此,可学习性问题也处于一种无法通过选择公理宇宙来解决的状态。

简单来说,研究中的数学证明表明,人工智能问题受到continuum hypothesis的影响,这意味着人工智能可能无法解决许多问题。虽然这个悖论在今天对现实世界的AI问题的应用非常少,但对于该领域在将来的发展将是至关重要的。

悖论在现实世界的机器学习问题中无处不在。也许有人说算法没有常识的概念,它们可能不受统计悖论的影响。然而,鉴于大多数机器学习问题需要人工分析和干预,并且基于人为策划的数据集,我们将在很长一段时间内生活在一个充满悖论的世界中。

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消