AI智能体使用日常语言生成解释其行为的原理

2019年04月19日 由 冯鸥 发表

671777

0

佐治亚理工学院、康奈尔大学和肯塔基大学合作开发了一种AI智能体,可以实时自动生成自然语言解释,以传达其行为背后的动机。这项工作旨在让人类与AI智能体或机器人合作,确保智能体正在正确地执行任务,并且可以解释错误或错误的行为。

佐治亚理工学院、康奈尔大学和肯塔基大学合作开发了一种AI智能体,可以实时自动生成自然语言解释,以传达其行为背后的动机。这项工作旨在让人类与AI智能体或机器人合作,确保智能体正在正确地执行任务,并且可以解释错误或错误的行为。智能体还使用非专家能够理解的日常语言。这些解释,或研究人员所称的“理性”,旨在引起人们的共鸣,并激发人们对那些可能在工作场中或社交场合中的机器人的信任。

“由于人工智能遍及我们生活的方方面面,因此非常需要以人为本的人工智能设计,使日常用户可以解释如同黑盒子的人工智能系统。我们需要理解基于语言的解释的作用以及如何让人类认识到它们。”

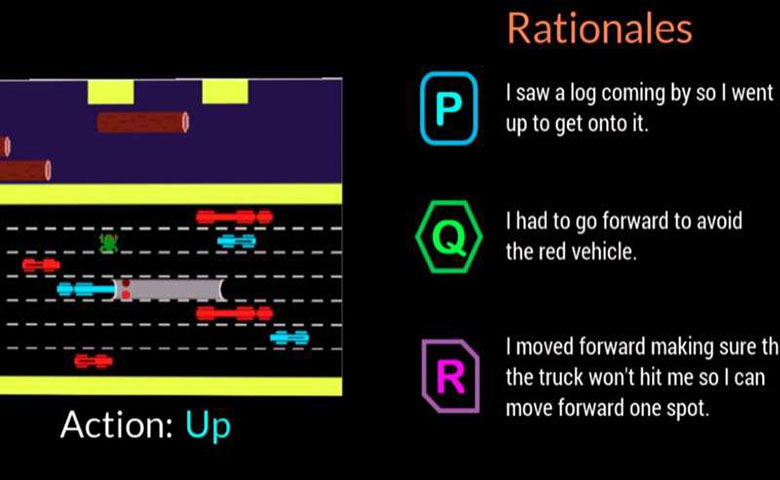

研究人员开展了一项参与者研究,以确定AI智能体能否提供模仿人类反应的理论依据。观众观看智能体玩视频游戏Frogger,然后根据每个人对人工智能游戏动作的描述程度,以描述AI移动的好坏对屏幕上列出的三个原理进行排序。

对于每一步的三个匿名判断,包括人类生成的响应,AI智能体生成的响应和随机生成的响应,参与者优先选择人类生成的理论,但AI生成的响应紧随其后。

Frogger为研究人员提供了在“顺序决策环境”中训练AI的机会,这是一项重大的研究挑战,因为智能体已经做出的决策会影响未来的决策。因此,研究人员表示,向专家解释推理链是困难的,在与非专家交流时更是如此。

参与者理解Frogger的目标是让青蛙安全回家,而不会被移动的车辆撞到或在河里淹死。向上,向下,向左或向右移动的简单游戏机制允许参与者看到AI正在做什么,并评估屏幕上的基本原理是否清楚地证明了移动的合理性。

参与者根据以下因素判断原理:

- 信心:这个人对AI执行任务充满信心

- 类人的:看起来像是由人类做出决定

- 充分的理由:充分证明采取的行动是正确的

- 可理解性:帮助人们理解AI的行为

AI生成的理论,在参与者中排名较高,表现出对环境条件和适应性的认可的理论,以及那些传达对未来危险的认识并为其规划的理论。冗余信息只是陈述了明显特征或错误地描述环境,这会产生负面影响。

“这个项目更多的是为了了解人类对这些人工智能系统的认知和偏好,而不是建立新技术,”Ehsan表示,“可解释性的核心是意义建构。我们试图理解这个人为因素。”

另一项相关研究证实,研究人员决定设计他们的AI智能体,使其能够提供两种不同类型的原理中的一种:

- 简洁的,专注的

- 整体的,全貌

在第二项研究中,参与者在观看AI玩Frogger后才获得AI生成的原理。他们被要求在人工智能出错的情况下选择他们更喜欢的答案,他们不知道原理分为两类。

四分之三的参与者赞成分类为“全貌”类别的答案。回应显示,人们欣赏人工智能对未来步骤的思考,而不仅仅是思考当下的事情,这可能会让他们更容易犯另一个错误。人们也想知道更多,这样他们就可以直接帮助人工智能纠正错误行为。

互动计算教授Mark Riedl表示,“对人工智能机器人的感知和偏好的理解,为我们提供了一套强大的可操作的见解,可以帮助我们设计出更好的以人为本,理性的、自主的智能体。”

研究的未来可能方向将把研究结果应用于各种类型的自主智能体,让它们根据手头的任务做出反应,例如它们可以应用在紧急响应救援,或是在教室帮助教师处理任务。

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消