AI机器人感知系统可以通过触摸物体来识别物体

2019年03月13日 由 冯鸥 发表

176412

0

人类通过触摸学习并了解世界。事实上,一些研究表明,动觉学习可以提高那些与视觉、听觉或读写学习紧密结合的学习效果。

人类通过触摸学习并了解世界。事实上,一些研究表明,动觉学习可以提高那些与视觉、听觉或读写学习紧密结合的学习效果。受到触摸力量的启发,加州大学伯克利分校的科学家设计了一种机器人感知框架,主要依靠触觉而不是视觉。在卡内基梅隆大学研究人员和其他人发表的工作基础上,他们着手设计一个AI系统,能够识别物理观察结果是否与特定物体相对应。

团队发表了论文“Learning to Identify Object Instances by Touch: Tactile Recognition via Multimodal Matching”,论文中写道,“人类自然会将物体的外观和材料特性与多种形态联系起来。我们的感知本质上是多模式的:当我们看到一个柔软的玩具时,我们会想象手指感觉到触摸柔软的表面,当我们感受到剪刀的边缘时,我们可以在脑海中想象它们,包括形状,粗糙度和比例,在这项工作中,我们研究了机器人操纵器如何学习类似的多模态关联。”

正如研究人员所解释的那样,相比之下,触觉传感器缺乏与图像传感器相同的全局视图,它们根据局部表面特性进行操作。此外,阅读往往更难以解释。

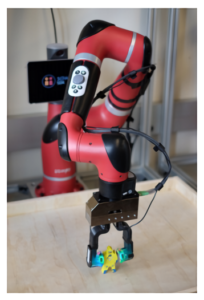

为了解决这些和其他限制,研究小组将高分辨率的GelSight触摸传感器与卷积神经网络结合在一起。前者能产生读数,后者能通过摄像头观察物体接触造成的凝胶变形。他们将两个GelSight传感器安装在一个平行的夹爪的手指上,当夹爪的手指成功地接触到目标物体时,他们用这个夹爪从相机的观察和触觉传感器的读数中收集数据。

团队总共收集了98个不同物体的样本,其中80个(包括27386个例子)用于训练上述神经网络,剩下的18中的6844个例子是为测试集保留的。

结果如何呢?在测试中,AI系统能够在64.3%的时间内准确地从触觉中推断出物体的身份,包括在训练期间没有遇到的物体。此外,该团队声称其表现优于类似的方法,包括在420项试验中的11名人类志愿者(加州大学伯克利分校本科生),他们被要求在握住东西时观察手指形状来识别物体。

这一方法还有改进的空间:所有图像都来自相同的环境,团队注意到他们只考虑了个体的掌握,而不是多重的触觉互动。尽管如此,他们认为这是迈向感知系统可以像人类一样从触摸中识别物体的第一步。

团队表示,“通过使机器人能够通过触摸识别物体,可以对机器人仓库进行成像,机器人通过在货架上感受到产品图像来检索物体,家中的机器人可以在难以接触的地方检索物体,也许通过多模式训练可以更深入地了解物体属性。”

论文:

arxiv.org/pdf/1903.03591.pdf

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消