谷歌通过自动强化学习实现远程机器人导航

2019年03月01日 由 Aaron 发表

884921

0

仅在美国就有300万人因行动不便而无法离开家。可以自动长距离导航的服务机器人可以提高行动不便人员的独立性,例如,为他们提供杂货,药品和包裹。

仅在美国就有300万人因行动不便而无法离开家。可以自动长距离导航的服务机器人可以提高行动不便人员的独立性,例如,为他们提供杂货,药品和包裹。研究表明,深度强化学习擅长将原始感官输入映射到动作,例如学习掌握物体和机器人运动,但强化学习智能体通常缺乏对大型物理空间的理解,无法在没有人类帮助的情况下安全地进行长距离航行,也无法轻松适应新的空间。

在最近的三篇论文中,团队通过将深度强化学习和长期规划相结合来研究易于适应的机器人自主性。通过训练本地规划智能体执行基本的导航行为,安全穿越短距离,不与移动障碍物碰撞。当地的规划者采用有噪声的传感器观测,例如提供到障碍物距离的一维激光雷达,并输出机器人控制的线速度和角速度。

然后使用AutoRL对局部规划器进行了仿真训练,AutoRL是一种自动搜索强化学习奖励和神经网络结构的方法。尽管它们的活动范围有限,只有10 - 15米,但当地的规划人员能够很好地将它们转移到真实的机器人和以前从未见过的新环境中。这使我们能够使用它们作为在大空间中导航的构建块。

构建一个路线图,一个节点是位置和边缘的图,只有当本地规划者能够可靠地在节点之间穿行时,这些规划者才能很好地模仿真实机器人的噪声传感器和控制。

自动化强化学习(AutoRL)

第一篇论文中,在小型静态环境中训练本地规划人员。然而,使用标准深度强化算法,例如深度确定性策略梯度(DDPG)进行训练会带来一些挑战。例如,本地规划者的真正目标是达到目标,这代表了稀疏的奖励。

在实践中,这需要研究人员花费大量时间来迭代和手动调整奖励。研究人员还必须在没有明确接受的最佳实践的情况下对神经网络架构做出决策。最后,像DDPG这样的算法是不稳定的学习者,并且经常表现出严重的遗忘。

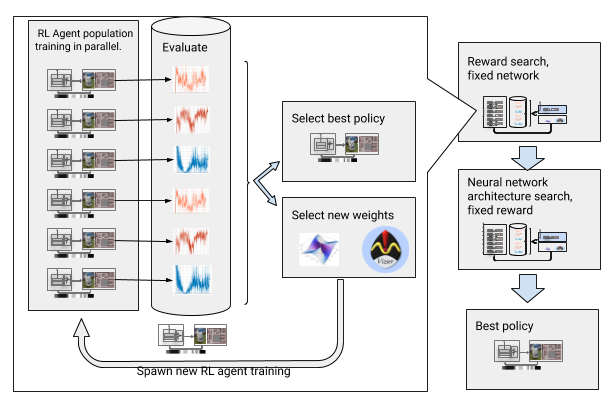

为了克服这些挑战,我们自动化深度强化学习训练。AutoRL是一个围绕深度强化学习的演化自动化层,它使用大规模超参数优化来搜索奖励和神经网络架构。它分两个阶段,奖励搜索和神经网络架构搜索。

在奖励搜索期间,AutoRL会在几代人的同时训练一群DDPG智能体,每个人都有一个稍微不同的奖励函数,优化本地规划者的真正目标:到达目的地。在奖励搜索阶段结束时,我们会选择最能引导智能体到达目的地的奖励。在神经网络架构搜索阶段,重复这个过程,使用选定的奖励并调整网络层,优化累积奖励。

使用奖励和神经网络架构搜索自动化强化学习

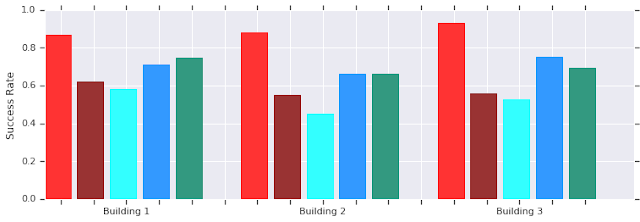

但是,这个迭代过程意味着AutoRL不具有样本效率。训练一名智能体需要500万个样本,对10代100个智能体进行AutoRL训练需要50亿个样本,相当于32年的培训。好处是,在AutoRL之后,训练过程是自动化的,DDPG不会出现严重的遗忘。最重要的是,由此产生的策略质量更高,AutoRL策略对传感器,执行器和本地化噪声具有鲁棒性,并且可以很好地适用于新环境。在测试环境中,最佳策略比其他导航方法提升26%。

AutoRL(红色)在几个看不见的建筑中成功完成了10米的短距离飞行。与手动调优的DDPG(深红色),人工势场(浅蓝色),动态窗口法(蓝色)和行为克隆(绿色)对比。

虽然这些策略仅能执行本地导航,但它们可以很好地移动障碍物并很好地转移到真实机器人,即使在非结构化环境中也是如此。虽然它们只接受静态障碍物的模拟训练,但它们也可以有效地处理移动物体。下一步是将AutoRL策略与基于抽样的计划相结合,以扩大其覆盖范围并实现远程导航。

使用PRM-RL实现远程导航

基于抽样的规划人员通过近似机器人运动来解决远程导航问题。例如,概率路线图(PRM)样本机器人构成并将它们与可行的过渡连接起来,创建路线图,捕捉机器人在大空间中的有效运动。

第二篇论文获得了ICRA 2018年服务机器人领域的最佳论文。在这篇论文中,我们将PRMs与基于手工调整的基于强化学习的本地规划者(没有AutoRL)结合起来,对机器人进行一次本地训练,然后让它们适应不同的环境。

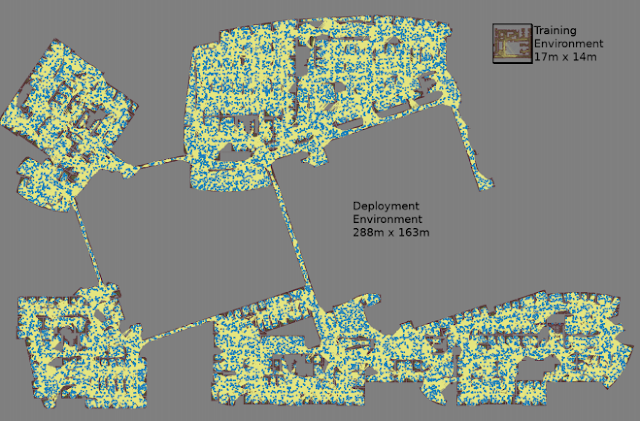

首先,对于每个机器人,团队在通用模拟训练环境中训练本地计划者策略。接下来,在部署环境的平面图上构建一个与该策略相关的PRM,称为PRM-RL。相同的平面图可以用于任何机器人,我们希望部署在建筑中的每个机器人环境设置一次。

为了构建PRM-RL,只有在基于强化学习的本地规划器(它能很好地表示机器人噪声)能够可靠且一致地在它们之间导航时才连接采样节点。这是通过蒙特卡洛完成的模拟。生成的路线图适用于特定机器人的能力和几何形状。具有相同几何形状但不同传感器和执行器的机器人的路线图将具有不同的连接性。

由于智能体可以在拐角处导航,因此包括没有清晰视线的节点。而由于传感器噪声,靠近墙壁和障碍物的节点不太可能连接到路线图中。在执行时,强化学习智能体从一个路标点导航到另一个路标点。

最大的地图长288米,宽163米,包含近70万条边,在4天的时间里,300名工作人员在一个需要11亿次碰撞检查的集群中收集。

第三篇论文对原有的PRM-RL进行了改进。首先,将手动调优的DDPG替换为经过AutoRL训练的本地规划器,从而改进远程导航。其次,它添加了同步定位和映射(SLAM)地图,机器人在执行时使用该地图作为构建路线图的来源。

由于SLAM地图是有噪声的,这种变化缩小了sim2real的差距,sim2real是机器人领域的一种现象,在这种情况下,经过模拟训练的代理在被转移到真实机器人上时明显表现不佳。团队的模拟成功率与机器人实验相同。最后,团队添加了分布式路线图构建,生成了包含70万个节点的大规模路线图。

之后,使用AutoRL智能体评估了该方法,利用比训练环境大200倍的办公室楼层地图构建路线图,在20次试验中达到至少90%的成功率。我们将PRM-RL与各种不同方法进行了比较,距离可达100米,远远超出了本地的规划范围。PRM-RL的成功率是基线的2到3倍,因为节点的连接与机器人的能力相适应。

在几座建筑物中导航超过100米的成功率。第一篇论文:AutoRL仅限本地策划者(蓝色);原始PRM(红色);路径引导的人工势场(黄色);第二篇论文(绿色);第三篇论文:使用AutoRL(橙色)的PRM。

团队在多个真实机器人和真实建筑工地上测试了PRM-RL。一组测试如下所示,机器人非常强大,但在凌乱的区域附近和SLAM地图的边缘还是表现不佳。

结论

自主机器人导航可以显著提高行动不便人群的独立性。我们可以通过开发易于适应的机器人来实现这一目标,包括可以使用已有的信息在新环境中部署的方法。

这是通过使用AutoRL自动学习基本的短程导航行为并将这些学习的策略与SLAM地图结合使用来构建路线图来完成的。这些路线图由通过边缘连接的节点组成,机器人可以一致地遍历这些节点。结果是,经过训练的策略可以在不同的环境中使用,并且可以生成针对特定机器人定制的路线图。

论文1:

ieeexplore.ieee.org/document/8643443

论文2:

ai.google/research/pubs/pub46570

论文3:

arxiv.org/abs/1902.09458

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消