Berkeley共享自主研究:人-机组合应用model-free RL,优化无人机实时辅助控制

2018年04月20日 由 浅浅 发表

665245

0

图为Lunar Lander游戏

左:不清楚摄像头指向位置的自主智能体飞行员;

中:未达到最佳标准的人类飞行员;

右:人-机组合

想象这样一个场景,无人机驾驶员远程操控一架四旋翼飞行器,用机载摄像头进行导航和着陆。不熟练的飞行动态、陌生的地形和网络延迟都会影响这个系统,使得人很难对其进行控制。解决这个问题的方法之一便是训练自主智能体,使其在没有人工干预的情况下,执行巡查和绘图之类的任务。只有当任务描述明确,且代理能观察到所有它需要的信息时,这种策略才会有效。

遗憾的是,许多涉及人类用户的实际应用程序并不满足这些条件:智能体通常不能完全理解用户的目的,其中一些隐含的信息智能体无法获得,另外任务可能会过于复杂,导致用户无法进行精确定义。例如,飞行员可能想要追踪一组移动物体(例如一群动物),并在飞行中改变目标的优先级(比如关注那些意外受伤的个体)。

共享自主通过将用户输入与自动化帮助相结合来解决这个问题,换句话说,就是加强而不是取代人类的控制。

背景

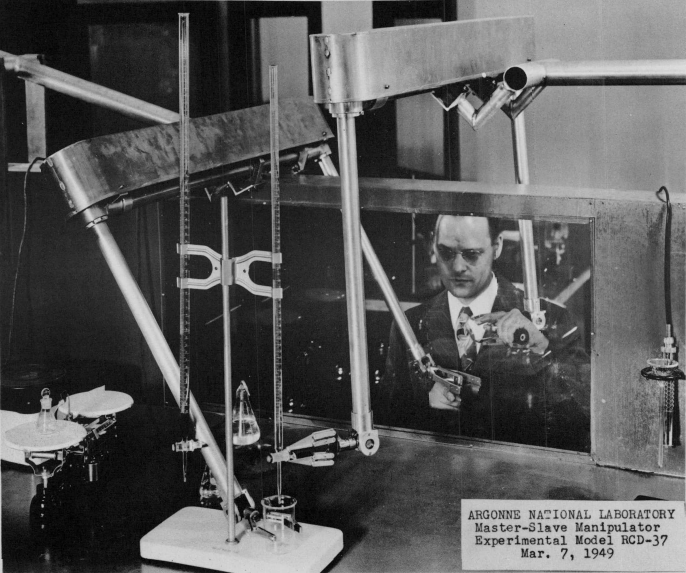

在共享控制系统中,将人类与人工智能相结合的观点最早可追溯到1949年,Ray Goertz的早期主从式操纵器,另外,1969年Ralph Mosher的Hardiman外骨骼和1980年Marvin Minsky的telepresence技术也都包含这一理念。经过对机器人学、人机交互和人工智能数十年的研究,人类操纵者和远程控制机器人的界面联系问题仍悬而未决。根据对2015年DARPA机器人挑战赛的回顾——“提高机器人性能最具成本效益的研究领域是人机交互……在DRC中,对机器人稳定性和性能影响最大的是操作员错误。开发避免和克服操作员错误的方法对于现实世界的机器人来说是至关重要的。人类操作员在压力下会犯错,尤其在现实情况下没有进行大量训练和练习更容易出错。”

主从式机械臂(Goertz, 1949)

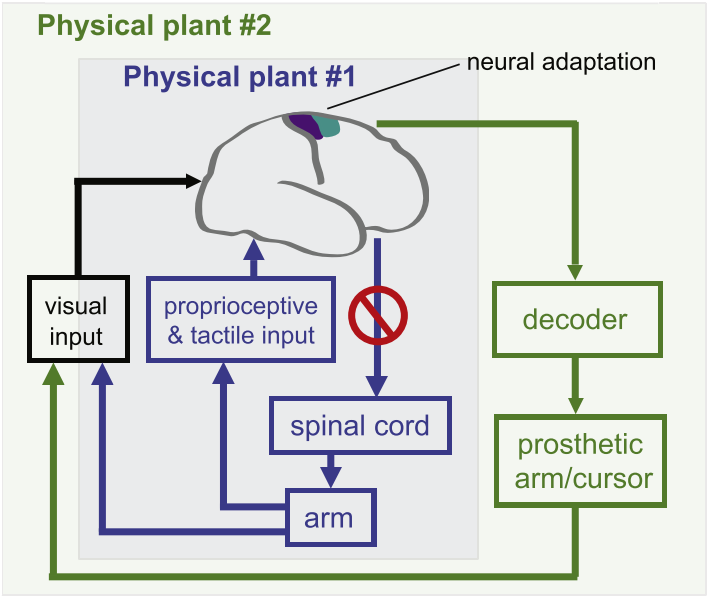

神经修复学的脑-机界面(Shenoy & Carmena, 2014)

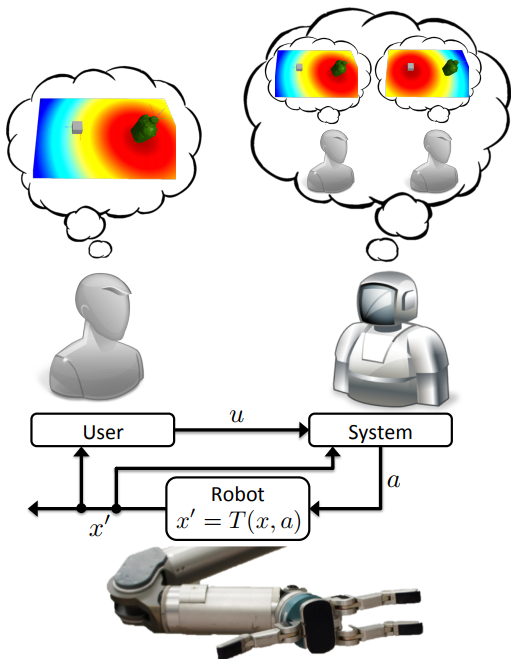

基于模型的自助共享形式体系(Javdani et al., 2015)

共享自主的一项研究是这样解决问题的:通过推断用户的目标,并用自主行动来实现这些目标。这种方法已经在改善驾驶员辅助、假肢的脑-机界面和辅助远程操作方面取得了进展,但需要事先了解现实世界的信息。明确来说,这些信息包括:(1)在给定的环境状态中做出预设动作,能够预测这一动作的结果的动态模型;(2)用户潜在的目标集;(3)描述用户对给定目标做出行为的观察模型。

有些领域中,可以直接硬编码或学习知识,基于模型的共享自主算法非常适合这些领域,但目标定义不明确,用户行为不可预测,这样的非结构化的环境中,这一算法仍有缺陷。我们从不同的角度来处理这个问题——使用深度强化学习来实现model-free共享自主。

深度强化学习利用神经网络功能,解决高维、连续态和行动空间等维度上的问题,最近在训练自主智能体从零开始玩视频游戏、击败其中的真人世界冠军以及控制机器人方面获得了显著的成功。对于回答如下问题我们已迈出了一步:深度强化学习是否有助于建立灵活实用的辅助系统?

人为介入的Model-Free强化学习(Model-Free RL with a Human in the Loop)

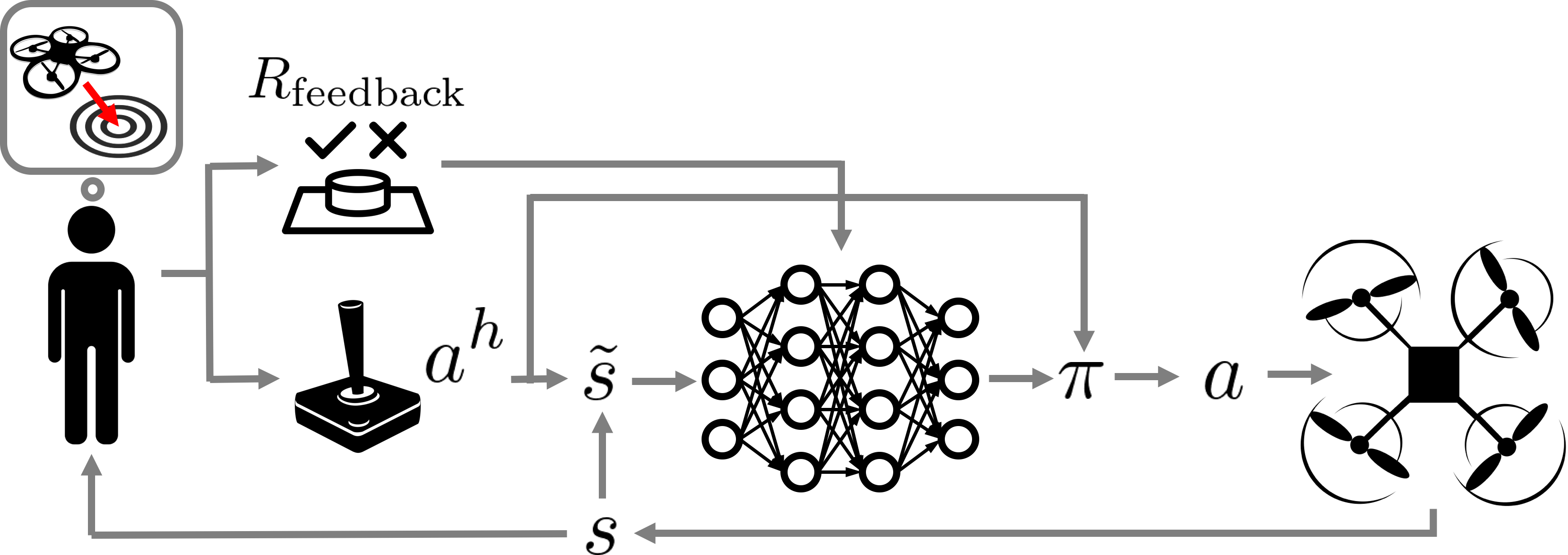

为了在最小限度的前提假设下进行共享控制远程操作,我们设计了一种model-free深度强化学习算法,用于共享自主。这一想法的关键是,根据环境观察与用户输入的智能体行动,学习其中的端到端映射内容,并将任务奖励作为唯一的监管形式。

从代理的角度来看,用户的行为就像可以进行优化调整的预先策略,并用额外的传感器生成观察结果,智能体可以由此间接解码用户的私人信息。从用户的角度来看,智能体的行为就像一个自适应界面,从用户命令和行动中学习了个性化的映射,将任务奖励最大化。

这项工作的核心挑战之一是,采用标准的深度强化学习技术,利用人类的控制输入,排除用户反馈控制回路产生的显著干扰,也不会因长时间的训练使他们感到疲劳。为了解决这些问题,我们使用深度Q-learning来学习一个近似的状态动作价值函数,在给定当前环境观察和用户输入的情况下,计算动作的预期返回值。有了这个价值函数,辅助智能体就会对用户的控制输入执行具有最高价值的行动。用户给智能体的奖励功能,是在每一状态下计算的已知术语组合,最终奖励则是用户在任务成功或失败时提供的。

图1显示了这一过程的高级示意图。

图1:人为介入的Model-Free强化学习之Q-learning算法

学习协助

预先的工作已经将共享自主定形为POMDP,在这个过程中,智能体最初并不知道用户的目标,它必须通过推断来完成任务。

现有的方法倾向于假定POMDP的以下部分是已知的:(1)环境的动力学,或者状态转换分布T;(2)用户的可能目标,或目标空间G;(3)用户对给定目标的控制策略,或者用户模型πh

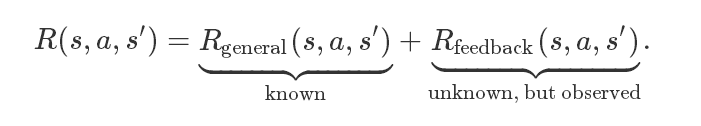

在研究中,我们放宽了这三个标准假设。引入了一种model-free深度强化学习方法,它能够在不了解这些知识的情况下提供协助,同时在信息已知的情况下也可以利用用户模型和目标空间。在我们的问题公式中,转换分布T,用户的策略πh,和目标空间G不再是智能体必须知道的信息。奖励函数取决于用户私人信息:

这种分解遵循典型存在于共享自主中的结构:在已知的奖励中有一些术语,比如避免碰撞的需要,是从Rgeneral中捕捉到的。Rfeedback则是用户生成的反馈,这取决于他们的私人信息。我们并不知道这个函数,只是假设通过用户提供反馈(例如按下一个按钮)来通知智能体。在实践中,用户可能只是简单指出智能体在每次试验中成功与否。

合并用户输入

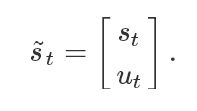

我们的方法是将智能体的环境观察结果st与来自用户的信息ut连接嵌入,形式如下:

ut的具体形式取决于可用的信息。正如大多数实验的情况,当我们不知道可能的目标G或用户给定目标的策略πh时,我们将ut赋给用户的行动

利用用户控制进行Q-learning

人为介入的model-free强化学习有两个挑战:(1)维护包含大量信息的用户输入(2)尽量最小化与环境的交互次数。如果用户输入是按照建议进行控制,始终忽略建议并采取不同的行动会降低用户输入的质量,因为人类依赖于他们的行动反馈来执行实时控制任务。在这种情况下,很难配置像TRPO这样流行的策略算法,因为它们不能保证忽略用户输入的频率。所以往往需要大量与环境的交互,而这对于人类用户来说是不切实际的。由于这两个标准,我们将目光转向深度Q-learning。

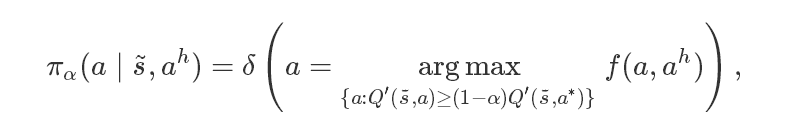

Q-learning是一种off-policy的算法,它使我们能够通过修改用于选择行动的策略,并且已给定了预期收益和用户输入,来解决上文中的问题(1)。最近关于并行自主和外侧环路稳定化的研究中,我们从最小化干涉原则的具体化过程中得到了灵感,执行了可行行动中最接近用户建议的方案,如果它没有比最佳行动差太多的话,行动就是可行的。公式如下:

f代表行动相似的函数,

对于问题(2),我们注意到,off-policy的Q-learning往往比策略梯度和Monte Carlo基于价值的方法更具样本有效性。我们的行为策略结构也加速了用户在最优状态下的学习:对于适当大小的α,智能体学会了调整用户的策略,而不是从头开始执行任务。实际上,这意味着在学习的早期阶段,组成的人机团队的表现至少和没有被协助的人一样好,而不是在表现随机的水平。

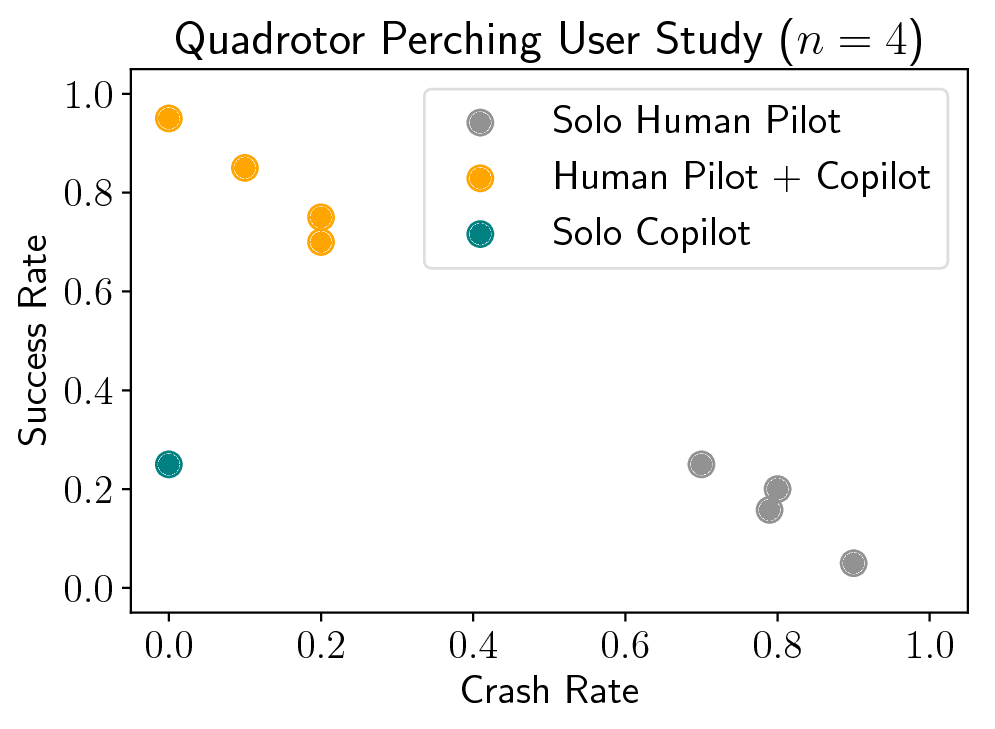

用户研究

我们将方法应用于两个实时辅助控制问题:月球登陆者游戏(Lunar Lander)和一个四旋翼飞行器着陆任务。这两项任务都是使用离散的动作空间和低维度状态观察来控制运动,包括观察位置、方向和速度信息。在这两项任务中,人类飞行员持有完成任务所必需的、但智能体无法理解的隐含信息,结果人类飞行员无法独立完成任务。

月球登陆者游戏

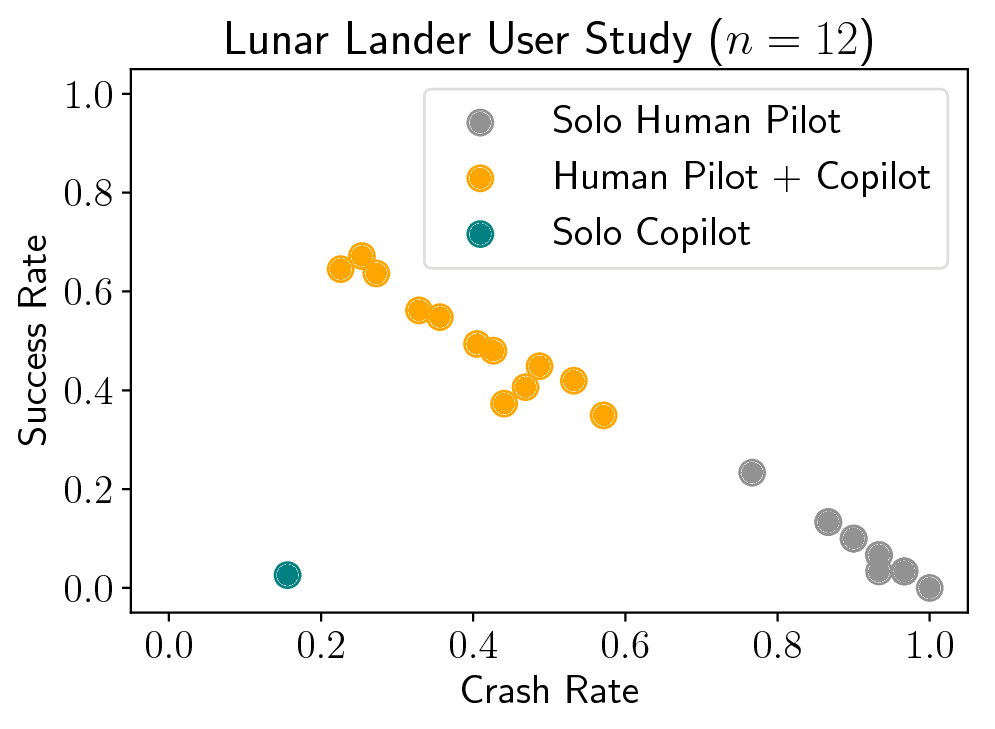

游戏目标是使用两个横向推进器和一个主引擎在旗帜之间着陆,坠毁或飞出界外即失败。提供辅助的副驾驶可以观察着陆器的位置、方向和速度,但看不到旗的位置。人类很少能独自获得胜利,但是有了副驾驶,表现就好多了。

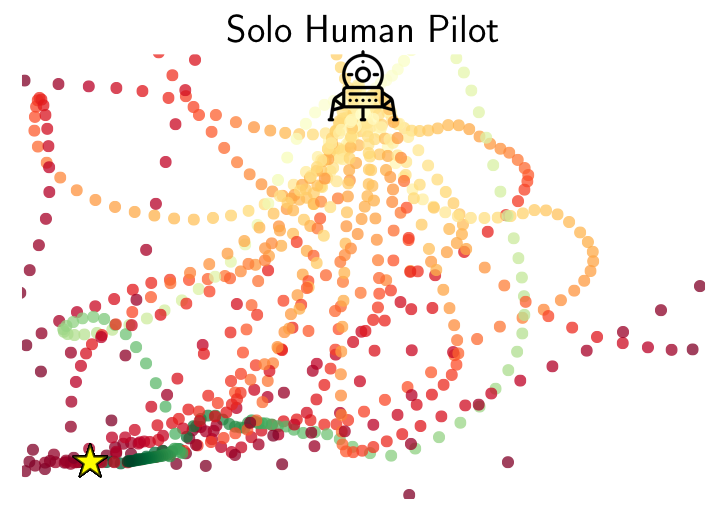

只有人类操纵的情况:人类飞行员无法稳定操控,不断坠机

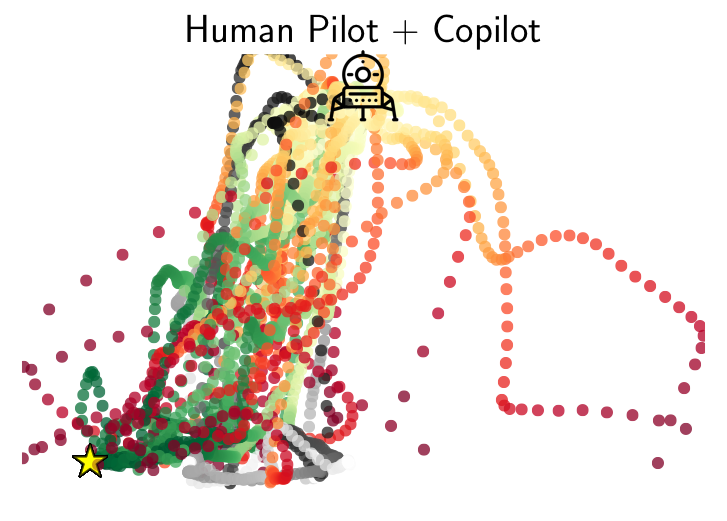

人类飞行员与深化学习副驾驶组合:副驾驶的加入让人类自由在旗间着陆,稳定性提升

图2a:30次的平均成功率和坠毁率

图2b-c:有和没有副驾驶飞行员的情况分别在游戏中的运行轨迹。红色轨迹在坠落或出界后失败,绿色代表成功,灰色轨迹是两种情况都不符。停机坪用一颗星星标记出来。为便于说明,只显示了着陆点在左边边界上的数据。

在使用人造实验模型的仿真实验中,我们还发现了一个显著的优势,那就是可以明确地推断出目标(如降落点的位置),而不是简单地将用户的原始控制输入添加到智能体的观察中,这表明在可用的情况下,目标空间和用户模型都能够被很好地利用。

分析月球登陆者游戏是有缺陷的,毕竟游戏界面和物理现象并不能反映真实世界中,机器人共享自主任务的复杂性和不可预测性。为了在更现实的环境中评估我们的方法,我们为操纵真正的四旋翼飞行器的人类飞行员制定了一项任务。

四旋翼飞行器着陆任务

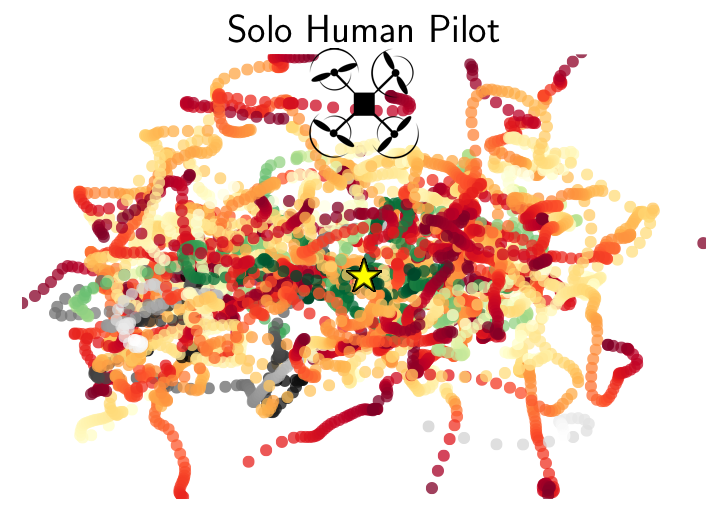

任务的目标是将Parrot AR-Drone 2降落在一块小的方形停机坪上,并且着陆点离它起飞的位置有一定距离,无人驾驶机的第一人称视角摄像头指向环境中的随机物体(例如红色椅子),避免其飞出边界或超出预定时间。飞行员使用键盘来控制速度,并且对他们屏蔽无人机第三人称视角的图像,这样他们只能依靠无人机的第一人称摄像头来进行导航和降落。辅助副驾驶观察到位置、方向和速度,但不知道飞行员要参照的物体是哪个。

单独的人类飞行员:飞行员的显示屏上只有无人机的第一人称视角,所以指示摄像头很简单,但很难找出着陆点。

人类飞行员与深化学习副驾驶组合:副驾驶并不知道飞行员要将摄像头指向哪里,但它知道着陆点的位置,合作完成了任务。

在时间限制下,在场景中将摄像机对准目标,同时将飞行器导航到一个可行着陆点的精确位置,是非常有挑战性的。辅助副驾驶在导航和着陆方面几乎没什么困难,但因为它不知道着陆后人类想要观察的东西,所以它也不知道应该将摄像头对准什么位置。而二者合作的话,人类指示摄像头,副驾驶可以专注于精准着陆。

超过20次测试的成功率和坠机率

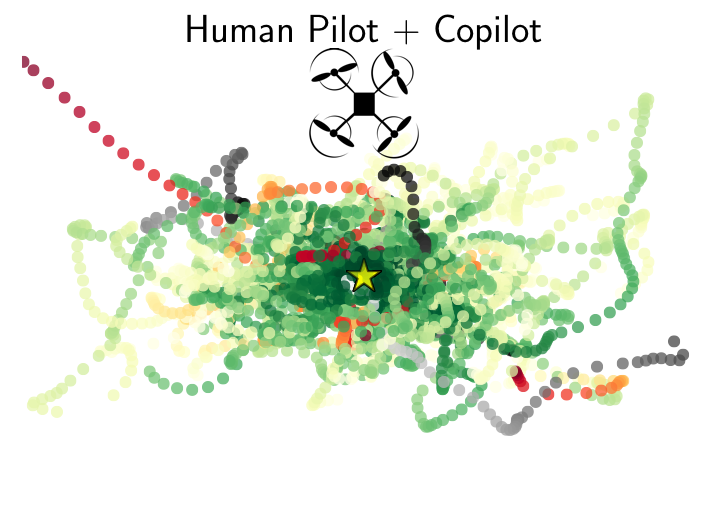

图3b-c:有和没有副驾驶出现的四旋翼飞行器着陆任务轨迹鸟瞰图。红色轨迹在坠落或出界后失败,绿色代表成功,灰色轨迹是两种情况都不符。停机坪用一颗星星标记出来。为便于说明,只显示了着陆点在左边边界上的数据。

我们得到的结果显示出人类驾驶员和机器副驾驶组合显著胜过两者分别单独完成任务。

展望

当然我们的方法也存在缺陷:model-free深度强化学习通常需要大量的训练数据,这对于操作机器人的人类用户来说是相当麻烦的。为了减少这一缺陷造成的影响,我们采用了在没有人类飞行员的情况下,对副驾驶进行预先模拟训练的方法。但问题是,这对于现实的应用程序并不总是可行的,因为难以构建高保真的模拟器,也不易设计丰富的用户不可知的奖励函数Rgeneral。研究者目前正在运用不同的方法来探索这个问题。

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消