在AI眼前“隐身”,用特制贴欺骗AI计算机视觉

2018年01月03日 由 yuxiangyu 发表

821128

0

虽然机器学习系统的能力很强,但他们并不聪明,因为他们缺乏常识。研究人员利用这一点对图像识别系统进行了一次精彩的攻击。他们对系统使用特殊印制的贴纸,这个贴纸会吸引AI的注意力,以至于让AI完全无法看到其他任何东西。(为什么我会觉得这个贴纸可能很快会成为流行配饰)

计算机视觉是一个非常复杂的问题,只有通过认知捷径的方式,人类才能正确地识别看到的东西,所以计算机要做同样的事情。

这些AI系统所采用的捷径之一就是不会为每个像素指定相同的重要性。假设有一张房子的照片,房子背后有天空,前面有一小块草地。一些基本的规则使计算机明白,尽管天空和草地都存在,但这不是“天空”或“草地”的图像。这样它考虑了这些背景,然后花费更多的时间来分析中间的形状。

谷歌的研究人员想知道:如果你破坏这个捷径,让计算机忽视这个房子,把注意力集中在他们选择的东西上会怎样?

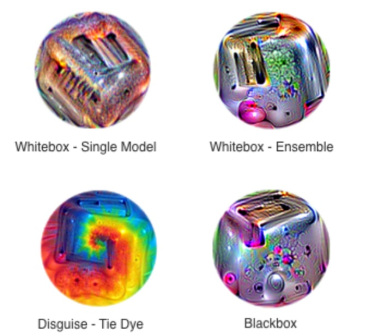

他们通过训练一个对抗系统来创建一个分散目标系统注意力的小圆圈,在圈内尝试许多颜色、形状和大小的配置,并观察哪些特征会引起图像识别器的注意。AI已经学会观察的特定曲线,指出除背景以外的其他颜色的组合等等。

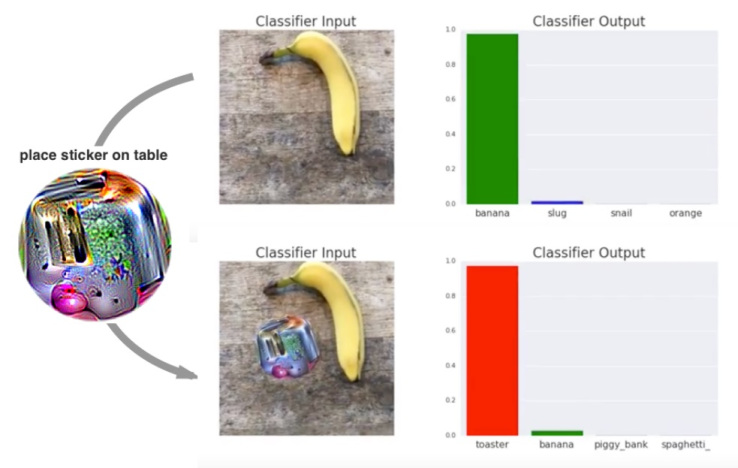

最终出现的效果如下:

把它放在系统已知的另一个物体旁边,例如香蕉,它会马上忘记香蕉,并认为这张图片是漩涡。图像中的名称表示创建贴纸并将其与现有图像合并的不同方法。

这个贴纸是基于特定系统而不是基于特定图像做出的,也就是说,无论图像识别系统在看什么,这个贴纸都会干扰它。

我们可以利用它做些什么?如果在你的衣服或包上粘上几个,也许机场或警察机构的图像分类器会分心,以至于不会记录你的存在。不过,如果你想实现这一点,你必须知道它上面运行着什么系统,然后测试几千种不同的贴纸图案才行。所以在这里我们只是提出了一种可能性。

以往欺骗计算机视觉系统的尝试通常依赖于反复对图像进行小的改动,以确定是否能在一些战略性的位置上改变少量像素来达成目的(例如将乌龟错认成枪支的研究)。但是这些研究人员称之为强的、高度区域化的“扰动”构成了另一个非常有趣的威胁。

我们的攻击会在现实世界中起作用,它可以伪装成无害的贴纸。这些结果表明可以离线创建的攻击,然后广泛共享...

即使人类能够注意到这些贴纸,他们也很难知道这个贴纸的作用,而是将其视为一种艺术形式。所以,这项工作表明,只注重防范小扰动是不够的,因为大的局部扰动也可能破坏分类器。

论文地址:https://arxiv.org/pdf/1712.09665.pdf

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消